From 591d5e48bfc5708b51c8bb28b1720709356f5b77 Mon Sep 17 00:00:00 2001

From: gongna <2036479155@qq.com>

Date: Wed, 31 Jul 2024 13:56:56 +0800

Subject: [PATCH] feat:Migrate all blog notes

---

_posts/2020-02-1-test-markdown.md | 76 +

_posts/2020-02-2-test-markdown.md | 66 +

.../2020-02-26-flake-it-till-you-make-it.md | 161 +-

_posts/2020-02-28-sample-markdown.md | 95 -

_posts/2020-02-28-test-markdown.md | 185 ++

_posts/2020-06-15-test-markdown.md | 67 +

_posts/2021-02-28-test-markdown.md | 105 +

_posts/2021-11-20-test-markdown.md | 88 +

_posts/2021-12-30-test-markdown.md | 254 ++

_posts/2022-02-15-test-markdown.md | 461 ++++

_posts/2022-02-19-test-markdown.md | 32 +

_posts/2022-03-14-test-markdown.md | 1133 +++++++++

_posts/2022-04-17-test-markdown.md | 270 ++

_posts/2022-04-18-test-markdown.md | 128 +

_posts/2022-04-20-test-markdown.md | 264 ++

_posts/2022-04-25-test-markdown.md | 326 +++

_posts/2022-05-18-test-markdown.md | 55 +

_posts/2022-05-20-test-markdown.md | 358 +++

_posts/2022-06-14-test-markdown.md | 77 +

_posts/2022-06-15-test-markdown.md | 162 ++

_posts/2022-07-08-test-markdown.md | 692 ++++++

_posts/2022-07-09test-markdown.md | 50 +

_posts/2022-07-11-test-markdown.md | 118 +

_posts/2022-07-12-test-markdown.md | 397 +++

_posts/2022-07-13-test-markdown.md | 726 ++++++

_posts/2022-07-14-test-markdown.md | 89 +

_posts/2022-07-15-test-markdown.md | 33 +

_posts/2022-07-16-test-markdown.md | 463 ++++

_posts/2022-07-17-test-markdown.md | 296 +++

_posts/2022-07-18-test-markdown.md | 433 ++++

_posts/2022-07-20-test-markdown.md | 60 +

_posts/2022-07-21-test-markdown.md | 233 ++

_posts/2022-07-22-test-markdown.md | 210 ++

_posts/2022-08-19-test-markdown.md | 326 +++

_posts/2022-08-20-test-markdown.md | 220 ++

_posts/2022-08-21-test-markdown.md | 92 +

_posts/2022-08-27-test-markdown.md | 174 ++

_posts/2022-08-28-test-markdown.md | 366 +++

_posts/2022-09-01-test-markdown.md | 57 +

_posts/2022-09-02-test-markdown.md | 223 ++

_posts/2022-09-04-test-markdown.md | 277 +++

_posts/2022-09-05-test-markdown.md | 962 ++++++++

_posts/2022-09-06-test-markdown.md | 239 ++

_posts/2022-10-02-test-markdown.md | 138 ++

_posts/2022-10-03-test-markdown.md | 127 +

_posts/2022-10-04-test-markdown.md | 898 +++++++

_posts/2022-10-05-test-markdown.md | 366 +++

_posts/2022-10-06-test-markdown.md | 58 +

_posts/2022-10-07-test-markdown.md | 547 +++++

_posts/2022-10-09-test-markdown.md | 973 ++++++++

_posts/2022-10-10-test-markdown.md | 88 +

_posts/2022-10-11-test-markdown.md | 292 +++

_posts/2022-10-12-test-markdown.md | 75 +

_posts/2022-10-13-test-markdown.md | 1134 +++++++++

_posts/2022-10-14-test-markdown.md | 149 ++

_posts/2022-10-15-test-markdown.md | 246 ++

_posts/2022-10-21-test-markdown.md | 14 +

_posts/2022-10-22-test-markdown.md | 23 +

_posts/2022-10-23-test-markdown.md | 7 +

_posts/2022-10-24-test-markdown.md | 115 +

_posts/2022-11-01-test-markdown.md | 79 +

_posts/2022-11-02-test-markdown.md | 436 ++++

_posts/2022-11-03-test-markdown.md | 1986 +++++++++++++++

_posts/2022-11-09-test-markdown.md | 604 +++++

_posts/2022-11-11-test-markdown.md | 216 ++

_posts/2022-11-12-test-markdown.md | 118 +

_posts/2022-11-19-test-markdown.md | 356 +++

_posts/2022-11-20-test-markdown.md | 183 ++

_posts/2022-11-21-test-markdown.md | 1568 ++++++++++++

_posts/2022-11-22-test-markdown.md | 190 ++

_posts/2022-11-23-test-markdown.md | 632 +++++

_posts/2022-11-24-test-markdown.md | 186 ++

_posts/2022-11-25-test-markdown.md | 133 +

_posts/2022-11-26-test-markdown.md | 407 ++++

_posts/2022-12-29-test-markdown.md | 287 +++

_posts/2022-12-31-test-markdown.md | 19 +

_posts/2022-12-5-test-markdown.md | 112 +

_posts/2022-12-6-test-markdown.md | 320 +++

_posts/2023-1-1-test-markdown.md | 200 ++

_posts/2023-1-10-test-markdown.md | 76 +

_posts/2023-1-16-test-markdown.md | 268 ++

_posts/2023-1-17-test-markdown.md | 170 ++

_posts/2023-1-18-test-markdown.md | 150 ++

_posts/2023-1-19-test-markdown.md | 1030 ++++++++

_posts/2023-1-20-test-markdown.md | 170 ++

_posts/2023-1-21-test-markdown.md | 273 +++

_posts/2023-1-22-test-markdown.md | 366 +++

_posts/2023-1-29-test-markdown.md | 346 +++

_posts/2023-1-3-test-markdown.md | 30 +

_posts/2023-1-30-test-markdown.md | 9 +

_posts/2023-1-31-test-markdown.md | 347 +++

_posts/2023-1-9-test-markdown.md | 37 +

_posts/2023-10-1-test-markdown.md | 46 +

_posts/2023-10-10-test-markdown.md | 289 +++

_posts/2023-10-11-test-markdown.md | 1406 +++++++++++

_posts/2023-10-12-test-markdown.md | 835 +++++++

_posts/2023-10-13-test-markdown.md | 909 +++++++

_posts/2023-10-14-test-markdown.md | 573 +++++

_posts/2023-10-15-test-markdown.md | 39 +

_posts/2023-10-16-test-markdown.md | 258 ++

_posts/2023-10-17-test-markdown.md | 369 +++

_posts/2023-10-18-test-markdown.md | 632 +++++

_posts/2023-10-19-test-markdown.md | 1103 +++++++++

_posts/2023-10-2-test-markdown.md | 128 +

_posts/2023-10-22-test-markdown.md | 83 +

_posts/2023-10-23-test-markdown.md | 223 ++

_posts/2023-10-3-test-markdown.md | 263 ++

_posts/2023-10-4-test-markdown.md | 87 +

_posts/2023-10-5-test-markdown.md | 278 +++

_posts/2023-10-6-test-markdown.md | 305 +++

_posts/2023-10-7-test-markdown.md | 1035 ++++++++

_posts/2023-10-8-test-markdown.md | 976 ++++++++

_posts/2023-10-9-test-markdown.md | 411 ++++

_posts/2023-11-10-test-markdown.md | 704 ++++++

_posts/2023-11-11-test-markdown.md | 215 ++

_posts/2023-11-12-test-markdown.md | 196 ++

_posts/2023-11-5-test-markdown.md | 364 +++

_posts/2023-11-6-test-markdown.md | 515 ++++

_posts/2023-11-7-test-markdown.md | 59 +

_posts/2023-11-9-test-markdown.md | 51 +

_posts/2023-2-1-test-markdown.md | 338 +++

_posts/2023-2-10-test-markdown.md | 797 ++++++

_posts/2023-2-2-test-markdown.md | 7 +

_posts/2023-2-20-test-markdown.md | 347 +++

_posts/2023-2-3-test-markdown.md | 91 +

_posts/2023-2-4-test-markdown.md | 276 +++

_posts/2023-3-27-test-markdown.md | 286 +++

_posts/2023-3-28-test-markdown.md | 335 +++

_posts/2023-4-10-test-markdown.md | 858 +++++++

_posts/2023-4-11-test-markdown.md | 198 ++

_posts/2023-4-13-test-markdown.md | 722 ++++++

_posts/2023-4-14-test-markdown.md | 83 +

_posts/2023-4-16-test-markdown.md | 782 ++++++

_posts/2023-4-17-test-markdown.md | 1251 ++++++++++

_posts/2023-4-19-test-markdown.md | 343 +++

_posts/2023-4-20-test-markdown.md | 1270 ++++++++++

_posts/2023-4-24-test-markdown.md | 566 +++++

_posts/2023-4-25-test-markdown.md | 459 ++++

_posts/2023-4-26-test-markdown.md | 160 ++

_posts/2023-4-27-test-markdown.md | 7 +

_posts/2023-4-29-test-markdown.md | 1047 ++++++++

_posts/2023-4-3-test-markdown.md | 534 ++++

_posts/2023-4-30-test-markdown.md | 35 +

_posts/2023-5-10-test-markdown.md | 1791 ++++++++++++++

_posts/2023-5-12-test-markdown.md | 1465 +++++++++++

_posts/2023-5-2-test-markdown.md | 146 ++

_posts/2023-5-21-test-markdown.md | 299 +++

_posts/2023-5-22-test-markdown.md | 219 ++

_posts/2023-5-23-test-markdown.md | 641 +++++

_posts/2023-5-24-test-markdown.md | 371 +++

_posts/2023-5-29-test-markdown.md | 555 +++++

_posts/2023-5-30-test-markdown.md | 154 ++

_posts/2023-5-7-test-markdown.md | 1006 ++++++++

_posts/2023-5-8-test-markdown.md | 2165 +++++++++++++++++

_posts/2023-6-1-test-markdown.md | 169 ++

_posts/2023-7-20-test-markdown.md | 117 +

_posts/2023-7-21-test-markdown.md | 10 +

_posts/2023-7-29-test-markdown.md | 347 +++

_posts/2023-8-29-test-markdown.md | 415 ++++

_posts/2023-8-30-test-markdown.md | 320 +++

_posts/2023-9-1-test-markdown.md | 333 +++

_posts/2023-9-10-test-markdown.md | 696 ++++++

_posts/2023-9-12-test-markdown.md | 433 ++++

_posts/2023-9-13-test-markdown.md | 2138 ++++++++++++++++

_posts/2023-9-2-test-markdown.md | 885 +++++++

_posts/2023-9-20-test-markdown.md | 48 +

_posts/2023-9-21-test-markdown.md | 250 ++

_posts/2023-9-22-test-markdown.md | 125 +

_posts/2023-9-23-test-markdown.md | 430 ++++

_posts/2023-9-24-test-markdown.md | 123 +

_posts/2023-9-25-test-markdown.md | 1071 ++++++++

_posts/2023-9-26-test-markdown.md | 125 +

_posts/2023-9-27-test-markdown.md | 61 +

_posts/2023-9-28-test-markdown.md | 478 ++++

_posts/2023-9-29-test-markdown.md | 542 +++++

_posts/2023-9-30-test-markdown.md | 404 +++

_posts/2023-9-5-test-markdown.md | 545 +++++

_posts/2023-9-7-test-markdown.md | 1454 +++++++++++

_posts/2023-9-8-test-markdown.md | 544 +++++

_posts/2023-9-9-test-markdown.md | 1422 +++++++++++

_posts/2024-03-29-test-markdown.md | 208 ++

_posts/2024-07-29-test-markdown.md | 100 +

_posts/2024-07-7-test-markdown.md | 55 +

_posts/2024-07-8-test-markdown.md | 152 ++

_posts/2024-07-9-test-markdown.md | 154 ++

_posts/2024-1-23-test-markdown.md | 75 +

_posts/2024-11-13-test-markdown.md | 1037 ++++++++

_posts/2024-11-14-test-markdown.md | 199 ++

_posts/2024-11-15-test-markdown.md | 186 ++

_posts/2024-11-16-test-markdown.md | 397 +++

_posts/2024-11-17-test-markdown.md | 144 ++

_posts/2024-11-18-test-markdown.md | 334 +++

_posts/2024-11-19-test-markdown.md | 26 +

_posts/2024-11-20-test-markdown.md | 1706 +++++++++++++

_posts/2024-11-21-test-markdown.md | 133 +

_posts/2024-11-22-test-markdown.md | 197 ++

_posts/2024-11-24-test-markdown.md | 43 +

_posts/2024-11-8-test-markdown.md | 763 ++++++

_posts/2024-3-12-test-markdown.md | 81 +

199 files changed, 78978 insertions(+), 106 deletions(-)

create mode 100644 _posts/2020-02-1-test-markdown.md

create mode 100644 _posts/2020-02-2-test-markdown.md

delete mode 100644 _posts/2020-02-28-sample-markdown.md

create mode 100644 _posts/2020-02-28-test-markdown.md

create mode 100644 _posts/2020-06-15-test-markdown.md

create mode 100644 _posts/2021-02-28-test-markdown.md

create mode 100644 _posts/2021-11-20-test-markdown.md

create mode 100644 _posts/2021-12-30-test-markdown.md

create mode 100644 _posts/2022-02-15-test-markdown.md

create mode 100644 _posts/2022-02-19-test-markdown.md

create mode 100644 _posts/2022-03-14-test-markdown.md

create mode 100644 _posts/2022-04-17-test-markdown.md

create mode 100644 _posts/2022-04-18-test-markdown.md

create mode 100644 _posts/2022-04-20-test-markdown.md

create mode 100644 _posts/2022-04-25-test-markdown.md

create mode 100644 _posts/2022-05-18-test-markdown.md

create mode 100644 _posts/2022-05-20-test-markdown.md

create mode 100644 _posts/2022-06-14-test-markdown.md

create mode 100644 _posts/2022-06-15-test-markdown.md

create mode 100644 _posts/2022-07-08-test-markdown.md

create mode 100644 _posts/2022-07-09test-markdown.md

create mode 100644 _posts/2022-07-11-test-markdown.md

create mode 100644 _posts/2022-07-12-test-markdown.md

create mode 100644 _posts/2022-07-13-test-markdown.md

create mode 100644 _posts/2022-07-14-test-markdown.md

create mode 100644 _posts/2022-07-15-test-markdown.md

create mode 100644 _posts/2022-07-16-test-markdown.md

create mode 100644 _posts/2022-07-17-test-markdown.md

create mode 100644 _posts/2022-07-18-test-markdown.md

create mode 100644 _posts/2022-07-20-test-markdown.md

create mode 100644 _posts/2022-07-21-test-markdown.md

create mode 100644 _posts/2022-07-22-test-markdown.md

create mode 100644 _posts/2022-08-19-test-markdown.md

create mode 100644 _posts/2022-08-20-test-markdown.md

create mode 100644 _posts/2022-08-21-test-markdown.md

create mode 100644 _posts/2022-08-27-test-markdown.md

create mode 100644 _posts/2022-08-28-test-markdown.md

create mode 100644 _posts/2022-09-01-test-markdown.md

create mode 100644 _posts/2022-09-02-test-markdown.md

create mode 100644 _posts/2022-09-04-test-markdown.md

create mode 100644 _posts/2022-09-05-test-markdown.md

create mode 100644 _posts/2022-09-06-test-markdown.md

create mode 100644 _posts/2022-10-02-test-markdown.md

create mode 100644 _posts/2022-10-03-test-markdown.md

create mode 100644 _posts/2022-10-04-test-markdown.md

create mode 100644 _posts/2022-10-05-test-markdown.md

create mode 100644 _posts/2022-10-06-test-markdown.md

create mode 100644 _posts/2022-10-07-test-markdown.md

create mode 100644 _posts/2022-10-09-test-markdown.md

create mode 100644 _posts/2022-10-10-test-markdown.md

create mode 100644 _posts/2022-10-11-test-markdown.md

create mode 100644 _posts/2022-10-12-test-markdown.md

create mode 100644 _posts/2022-10-13-test-markdown.md

create mode 100644 _posts/2022-10-14-test-markdown.md

create mode 100644 _posts/2022-10-15-test-markdown.md

create mode 100644 _posts/2022-10-21-test-markdown.md

create mode 100644 _posts/2022-10-22-test-markdown.md

create mode 100644 _posts/2022-10-23-test-markdown.md

create mode 100644 _posts/2022-10-24-test-markdown.md

create mode 100644 _posts/2022-11-01-test-markdown.md

create mode 100644 _posts/2022-11-02-test-markdown.md

create mode 100644 _posts/2022-11-03-test-markdown.md

create mode 100644 _posts/2022-11-09-test-markdown.md

create mode 100644 _posts/2022-11-11-test-markdown.md

create mode 100644 _posts/2022-11-12-test-markdown.md

create mode 100644 _posts/2022-11-19-test-markdown.md

create mode 100644 _posts/2022-11-20-test-markdown.md

create mode 100644 _posts/2022-11-21-test-markdown.md

create mode 100644 _posts/2022-11-22-test-markdown.md

create mode 100644 _posts/2022-11-23-test-markdown.md

create mode 100644 _posts/2022-11-24-test-markdown.md

create mode 100644 _posts/2022-11-25-test-markdown.md

create mode 100644 _posts/2022-11-26-test-markdown.md

create mode 100644 _posts/2022-12-29-test-markdown.md

create mode 100644 _posts/2022-12-31-test-markdown.md

create mode 100644 _posts/2022-12-5-test-markdown.md

create mode 100644 _posts/2022-12-6-test-markdown.md

create mode 100644 _posts/2023-1-1-test-markdown.md

create mode 100644 _posts/2023-1-10-test-markdown.md

create mode 100644 _posts/2023-1-16-test-markdown.md

create mode 100644 _posts/2023-1-17-test-markdown.md

create mode 100644 _posts/2023-1-18-test-markdown.md

create mode 100644 _posts/2023-1-19-test-markdown.md

create mode 100644 _posts/2023-1-20-test-markdown.md

create mode 100644 _posts/2023-1-21-test-markdown.md

create mode 100644 _posts/2023-1-22-test-markdown.md

create mode 100644 _posts/2023-1-29-test-markdown.md

create mode 100644 _posts/2023-1-3-test-markdown.md

create mode 100644 _posts/2023-1-30-test-markdown.md

create mode 100644 _posts/2023-1-31-test-markdown.md

create mode 100644 _posts/2023-1-9-test-markdown.md

create mode 100644 _posts/2023-10-1-test-markdown.md

create mode 100644 _posts/2023-10-10-test-markdown.md

create mode 100644 _posts/2023-10-11-test-markdown.md

create mode 100644 _posts/2023-10-12-test-markdown.md

create mode 100644 _posts/2023-10-13-test-markdown.md

create mode 100644 _posts/2023-10-14-test-markdown.md

create mode 100644 _posts/2023-10-15-test-markdown.md

create mode 100644 _posts/2023-10-16-test-markdown.md

create mode 100644 _posts/2023-10-17-test-markdown.md

create mode 100644 _posts/2023-10-18-test-markdown.md

create mode 100644 _posts/2023-10-19-test-markdown.md

create mode 100644 _posts/2023-10-2-test-markdown.md

create mode 100644 _posts/2023-10-22-test-markdown.md

create mode 100644 _posts/2023-10-23-test-markdown.md

create mode 100644 _posts/2023-10-3-test-markdown.md

create mode 100644 _posts/2023-10-4-test-markdown.md

create mode 100644 _posts/2023-10-5-test-markdown.md

create mode 100644 _posts/2023-10-6-test-markdown.md

create mode 100644 _posts/2023-10-7-test-markdown.md

create mode 100644 _posts/2023-10-8-test-markdown.md

create mode 100644 _posts/2023-10-9-test-markdown.md

create mode 100644 _posts/2023-11-10-test-markdown.md

create mode 100644 _posts/2023-11-11-test-markdown.md

create mode 100644 _posts/2023-11-12-test-markdown.md

create mode 100644 _posts/2023-11-5-test-markdown.md

create mode 100644 _posts/2023-11-6-test-markdown.md

create mode 100644 _posts/2023-11-7-test-markdown.md

create mode 100644 _posts/2023-11-9-test-markdown.md

create mode 100644 _posts/2023-2-1-test-markdown.md

create mode 100644 _posts/2023-2-10-test-markdown.md

create mode 100644 _posts/2023-2-2-test-markdown.md

create mode 100644 _posts/2023-2-20-test-markdown.md

create mode 100644 _posts/2023-2-3-test-markdown.md

create mode 100644 _posts/2023-2-4-test-markdown.md

create mode 100644 _posts/2023-3-27-test-markdown.md

create mode 100644 _posts/2023-3-28-test-markdown.md

create mode 100644 _posts/2023-4-10-test-markdown.md

create mode 100644 _posts/2023-4-11-test-markdown.md

create mode 100644 _posts/2023-4-13-test-markdown.md

create mode 100644 _posts/2023-4-14-test-markdown.md

create mode 100644 _posts/2023-4-16-test-markdown.md

create mode 100644 _posts/2023-4-17-test-markdown.md

create mode 100644 _posts/2023-4-19-test-markdown.md

create mode 100644 _posts/2023-4-20-test-markdown.md

create mode 100644 _posts/2023-4-24-test-markdown.md

create mode 100644 _posts/2023-4-25-test-markdown.md

create mode 100644 _posts/2023-4-26-test-markdown.md

create mode 100644 _posts/2023-4-27-test-markdown.md

create mode 100644 _posts/2023-4-29-test-markdown.md

create mode 100644 _posts/2023-4-3-test-markdown.md

create mode 100644 _posts/2023-4-30-test-markdown.md

create mode 100644 _posts/2023-5-10-test-markdown.md

create mode 100644 _posts/2023-5-12-test-markdown.md

create mode 100644 _posts/2023-5-2-test-markdown.md

create mode 100644 _posts/2023-5-21-test-markdown.md

create mode 100644 _posts/2023-5-22-test-markdown.md

create mode 100644 _posts/2023-5-23-test-markdown.md

create mode 100644 _posts/2023-5-24-test-markdown.md

create mode 100644 _posts/2023-5-29-test-markdown.md

create mode 100644 _posts/2023-5-30-test-markdown.md

create mode 100644 _posts/2023-5-7-test-markdown.md

create mode 100644 _posts/2023-5-8-test-markdown.md

create mode 100644 _posts/2023-6-1-test-markdown.md

create mode 100644 _posts/2023-7-20-test-markdown.md

create mode 100644 _posts/2023-7-21-test-markdown.md

create mode 100644 _posts/2023-7-29-test-markdown.md

create mode 100644 _posts/2023-8-29-test-markdown.md

create mode 100644 _posts/2023-8-30-test-markdown.md

create mode 100644 _posts/2023-9-1-test-markdown.md

create mode 100644 _posts/2023-9-10-test-markdown.md

create mode 100644 _posts/2023-9-12-test-markdown.md

create mode 100644 _posts/2023-9-13-test-markdown.md

create mode 100644 _posts/2023-9-2-test-markdown.md

create mode 100644 _posts/2023-9-20-test-markdown.md

create mode 100644 _posts/2023-9-21-test-markdown.md

create mode 100644 _posts/2023-9-22-test-markdown.md

create mode 100644 _posts/2023-9-23-test-markdown.md

create mode 100644 _posts/2023-9-24-test-markdown.md

create mode 100644 _posts/2023-9-25-test-markdown.md

create mode 100644 _posts/2023-9-26-test-markdown.md

create mode 100644 _posts/2023-9-27-test-markdown.md

create mode 100644 _posts/2023-9-28-test-markdown.md

create mode 100644 _posts/2023-9-29-test-markdown.md

create mode 100644 _posts/2023-9-30-test-markdown.md

create mode 100644 _posts/2023-9-5-test-markdown.md

create mode 100644 _posts/2023-9-7-test-markdown.md

create mode 100644 _posts/2023-9-8-test-markdown.md

create mode 100644 _posts/2023-9-9-test-markdown.md

create mode 100644 _posts/2024-03-29-test-markdown.md

create mode 100644 _posts/2024-07-29-test-markdown.md

create mode 100644 _posts/2024-07-7-test-markdown.md

create mode 100644 _posts/2024-07-8-test-markdown.md

create mode 100644 _posts/2024-07-9-test-markdown.md

create mode 100644 _posts/2024-1-23-test-markdown.md

create mode 100644 _posts/2024-11-13-test-markdown.md

create mode 100644 _posts/2024-11-14-test-markdown.md

create mode 100644 _posts/2024-11-15-test-markdown.md

create mode 100644 _posts/2024-11-16-test-markdown.md

create mode 100644 _posts/2024-11-17-test-markdown.md

create mode 100644 _posts/2024-11-18-test-markdown.md

create mode 100644 _posts/2024-11-19-test-markdown.md

create mode 100644 _posts/2024-11-20-test-markdown.md

create mode 100644 _posts/2024-11-21-test-markdown.md

create mode 100644 _posts/2024-11-22-test-markdown.md

create mode 100644 _posts/2024-11-24-test-markdown.md

create mode 100644 _posts/2024-11-8-test-markdown.md

create mode 100644 _posts/2024-3-12-test-markdown.md

diff --git a/_posts/2020-02-1-test-markdown.md b/_posts/2020-02-1-test-markdown.md

new file mode 100644

index 000000000000..7541657f323a

--- /dev/null

+++ b/_posts/2020-02-1-test-markdown.md

@@ -0,0 +1,76 @@

+---

+layout: post

+title: HomeBrew卸载和安装

+subtitle:

+tags: [brew]

+comments: true

+---

+

+## HomeBrew卸载

+```shell

+/bin/zsh -c "$(curl -fsSL https://gitee.com/cunkai/HomebrewCN/raw/master/HomebrewUninstall.sh)"

+```

+

+## HomeBrew安装

+

+```shell

+/bin/zsh -c "$(curl -fsSL https://gitee.com/cunkai/HomebrewCN/raw/master/Homebrew.sh)"

+```

+

+## 设置环境变量

+

+为了将 node@18 加入到 PATH 环境变量中,使其成为优先选择的版本,可以运行以下命令:

+```shell

+echo 'export PATH="/opt/homebrew/opt/node@18/bin:$PATH"' >> ~/.zshrc

+```

+此命令将 export PATH=... 添加到的 ~/.zshrc 文件中,以确保 node@18 的二进制文件在的路径中优先被找到。

+

+另外,为了让编译器能找到 node@18,可能需要设置以下环境变量:

+

+

+```shell

+export LDFLAGS="-L/opt/homebrew/opt/node@18/lib"

+export CPPFLAGS="-I/opt/homebrew/opt/node@18/include"

+```

+

+这些环境变量指定了编译器在编译过程中需要搜索的库文件和头文件路径。设置这些变量可以确保在编译需要使用到 node@18 的程序时,编译器能够正确地找到所需的文件。

+

+

+## 更换Homebrew的镜像源

+可以通过以下步骤来更换Homebrew的镜像源:

+1. **更换Homebrew的formula源**:

+

+```shell

+# 切换到Homebrew的目录

+cd "$(brew --repo)"

+# 更换源

+git remote set-url origin https://mirrors.tuna.tsinghua.edu.cn/git/homebrew/brew.git

+```

+

+1. **更换Homebrew的bottle源**:

+

+在的shell配置文件(比如`~/.bash_profile`或者`~/.zshrc`)中添加以下行:

+

+```shell

+export HOMEBREW_BOTTLE_DOMAIN=https://mirrors.tuna.tsinghua.edu.cn/homebrew-bottles

+```

+

+然后运行`source ~/.bash_profile`或者`source ~/.zshrc`来使更改生效。

+

+1. **更换Homebrew的核心formula源**:

+

+```shell

+# 切换到Homebrew的目录

+cd "$(brew --repo)/Library/Taps/homebrew/homebrew-core"

+

+# 更换源

+git remote set-url origin https://mirrors.tuna.tsinghua.edu.cn/git/homebrew/homebrew-core.git

+```

+

+以上步骤将Homebrew的源更换为了清华大学的镜像站点,可以根据需要更换为其他的镜像站点。

+

+注意:如果在更换源之后遇到了问题,可以通过运行以上命令并将URL更换为官方源的URL来恢复到官方源。官方源的URL分别为:

+

+- Homebrew:https://github.com/Homebrew/brew.git

+- Homebrew Bottles:https://homebrew.bintray.com/bottles

+- Homebrew Core:https://github.com/Homebrew/homebrew-core.git

\ No newline at end of file

diff --git a/_posts/2020-02-2-test-markdown.md b/_posts/2020-02-2-test-markdown.md

new file mode 100644

index 000000000000..1c9b972a8bf1

--- /dev/null

+++ b/_posts/2020-02-2-test-markdown.md

@@ -0,0 +1,66 @@

+---

+layout: post

+title: HomeBrew安装ETCD

+subtitle:

+tags: [etcd]

+comments: true

+---

+

+## 使用 brew 安装

+

+第一步: 确定 brew 是否有 etcd 包:

+```shell

+brew search etcd

+```

+避免盲目使用 brew install balabala

+

+第二步: 安装

+```shell

+brew install etcd

+```

+

+第三步:运行

+推荐使用 brew services 来管理这些应用。

+

+```shell

+brew list

+```

+```shell

+brew services list

+```

+```shell

+brew services list

+Name Status User Plist

+etcd started bigbug/Library/LaunchAgents/homebrew.mxcl.etcd.plist

+privoxy started bigbug/Library/LaunchAgents/homebrew.mxcl.privoxy.plist

+redis stopped

+可以看到,我本机的 etcd 已经是启动的状态,所以我可以直接使用。

+```

+

+brew services 常用的操作

+

+### 启动某个应用,这里用 etcd 做演示

+```shell

+brew services start etcd

+```

+

+### 停止某个应用

+```shell

+brew services stop etcd

+```

+

+### 查看当前应用列表

+```shell

+brew services list

+```

+好了, etcd 已经启动了,现在验证下,是否正确的启动:

+### 验证

+```shell

+etcdctl endpoint health

+```

+正常情况会输出:

+

+```shell

+127.0.0.1:2379 is healthy: successfully committed proposal: took = 2.258149ms

+```

+至此,etcd 已经安装完毕。

\ No newline at end of file

diff --git a/_posts/2020-02-26-flake-it-till-you-make-it.md b/_posts/2020-02-26-flake-it-till-you-make-it.md

index 768f6328da09..f652cf138988 100644

--- a/_posts/2020-02-26-flake-it-till-you-make-it.md

+++ b/_posts/2020-02-26-flake-it-till-you-make-it.md

@@ -1,18 +1,157 @@

---

layout: post

-title: Flake it till you make it

-subtitle: Excerpt from Soulshaping by Jeff Brown

-cover-img: /assets/img/path.jpg

-thumbnail-img: /assets/img/thumb.png

-share-img: /assets/img/path.jpg

-tags: [books, test]

-author: Sharon Smith and Barry Simpson

+title: 中介者模式

+subtitle: 调解人、控制器、Intermediary、Controller、Mediator

+tags: [设计模式]

---

-Under what circumstances should we step off a path? When is it essential that we finish what we start? If I bought a bag of peanuts and had an allergic reaction, no one would fault me if I threw it out. If I ended a relationship with a woman who hit me, no one would say that I had a commitment problem. But if I walk away from a seemingly secure route because my soul has other ideas, I am a flake?

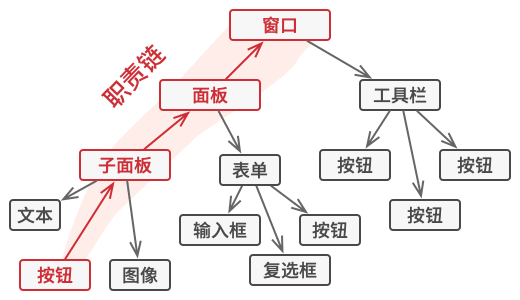

+# 中介者模式

-The truth is that no one else can definitively know the path we are here to walk. It’s tempting to listen—many of us long for the omnipotent other—but unless they are genuine psychic intuitives, they can’t know. All others can know is their own truth, and if they’ve actually done the work to excavate it, they will have the good sense to know that they cannot genuinely know anyone else’s. Only soul knows the path it is here to walk. Since you are the only one living in your temple, only you can know its scriptures and interpretive structure.

+> **亦称:** 调解人、控制器、Intermediary、Controller、Mediator

-At the heart of the struggle are two very different ideas of success—survival-driven and soul-driven. For survivalists, success is security, pragmatism, power over others. Success is the absence of material suffering, the nourishing of the soul be damned. It is an odd and ironic thing that most of the material power in our world often resides in the hands of younger souls. Still working in the egoic and material realms, they love the sensations of power and focus most of their energy on accumulation. Older souls tend not to be as materially driven. They have already played the worldly game in previous lives and they search for more subtle shades of meaning in this one—authentication rather than accumulation. They are often ignored by the culture at large, although they really are the truest warriors.

+

-A soulful notion of success rests on the actualization of our innate image. Success is simply the completion of a soul step, however unsightly it may be. We have finished what we started when the lesson is learned. What a fear-based culture calls a wonderful opportunity may be fruitless and misguided for the soul. Staying in a passionless relationship may satisfy our need for comfort, but it may stifle the soul. Becoming a famous lawyer is only worthwhile if the soul demands it. It is an essential failure if you are called to be a monastic this time around. If you need to explore and abandon ten careers in order to stretch your soul toward its innate image, then so be it. Flake it till you make it.

\ No newline at end of file

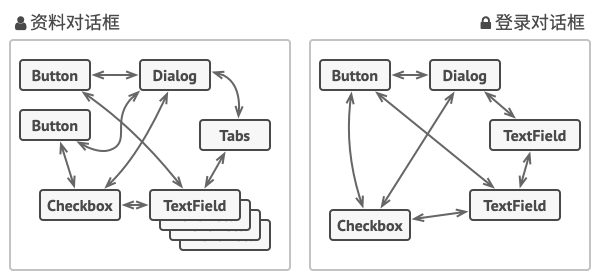

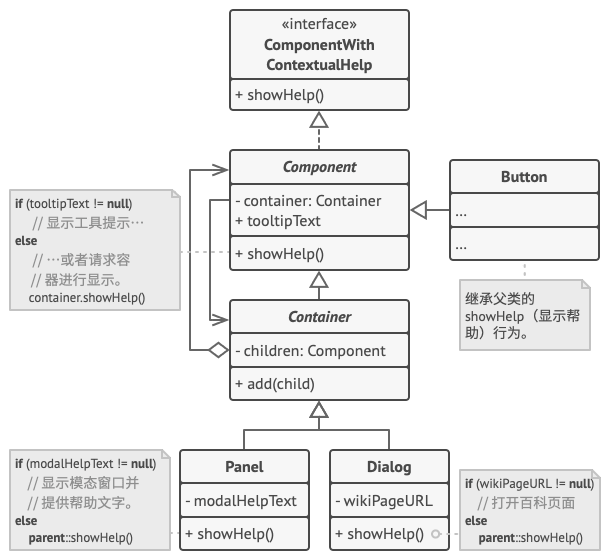

+## 1.概念

+

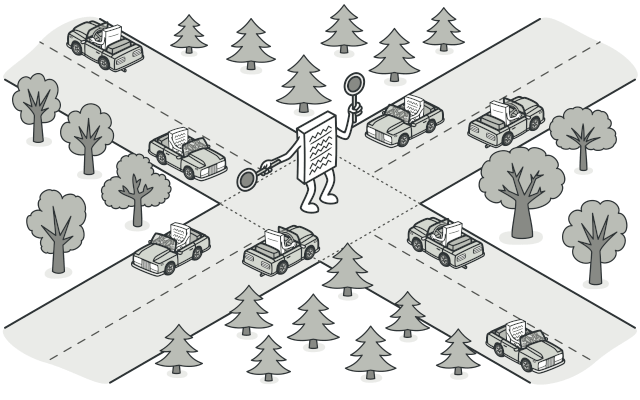

+**中介者模式**是一种行为设计模式, 能让减少对象之间混乱无序的依赖关系。 该模式会限制对象之间的直接交互, 迫使它们通过一个中介者对象进行合作。

+

+假如有一个创建和修改客户资料的对话框, 它由各种控件组成, 例如文本框 (TextField)、 复选框 (Checkbox) 和按钮 (Button) 等。

+

+

+- 元素间存在许多关联。 因此, 对某些元素进行修改可能会影响其他元素。

+

+- 如果直接在表单元素代码中实现业务逻辑, 将很难在程序其他表单中复用这些元素类。

+

+

+## 2.问题

+

+#### 1.元素可能会直接进行互动。

+

+提交按钮必须在保存数据前校验所有输入内容。

+

+#### 2.元素间存在许多关联

+

+对某些元素进行修改可能会影响其他元素

+

+#### 3.在元素代码中实现业务逻辑将很难复用其他的元素类

+

+

+## 3.解决方法

+

+> 中介者模式建议停止组件之间的直接交流并使其相互独立。 这些组件必须调用特殊的中介者对象, 通过中介者对象重定向调用行为, 以间接的方式进行合作。 最终, 组件仅依赖于一个中介者类, 无需与多个其他组件相耦合。

+

+在资料编辑表单的例子中, 对话框 (Dialog) 类本身将作为中介者, 其很可能已知自己所有的子元素, 因此甚至无需在该类中引入新的依赖关系。

+

+

+

+绝大部分重要的修改都在实际表单元素中进行。 想想提交按钮。 之前, 当用户点击按钮后, 它必须对所有表单元素数值进行校验。 而现在它的唯一工作是将点击事件通知给对话框。 收到通知后, 对话框可以自行校验数值或将任务委派给各元素。 这样一来, 按钮不再与多个表单元素相关联, 而仅依赖于对话框类。

+

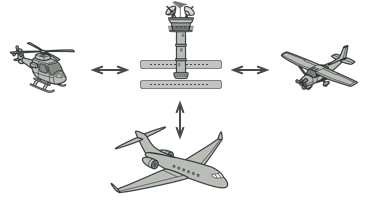

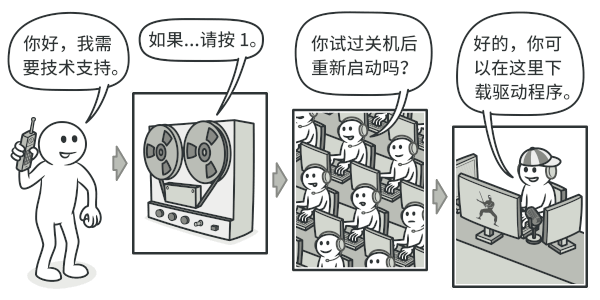

+## 4.类比

+

+

+

+> 飞行器驾驶员之间不会通过相互沟通来决定下一架降落的飞机。 所有沟通都通过控制塔台进行。飞行器驾驶员们在靠近或离开空中管制区域时不会直接相互交流。 但他们会与飞机跑道附近, 塔台中的空管员通话。 如果没有空管员, 驾驶员就需要留意机场附近的所有飞机, 并与数十位飞行员组成的委员会讨论降落顺序。 那恐怕会让飞机坠毁的统计数据一飞冲天吧。

+

+- 塔台无需管制飞行全程, 只需在航站区加强管控即可, 因为该区域的决策**参与者数量**对于飞行员来说实在**太多**了。

+

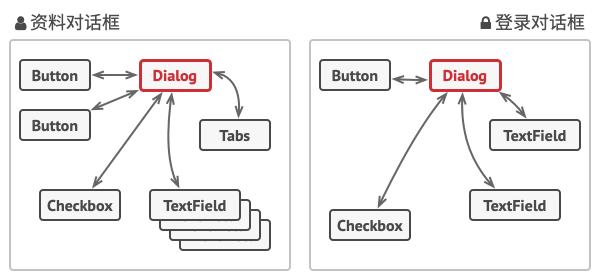

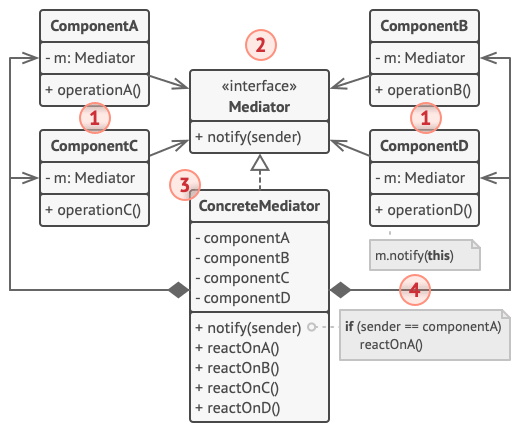

+## 5.中介者模式结构

+

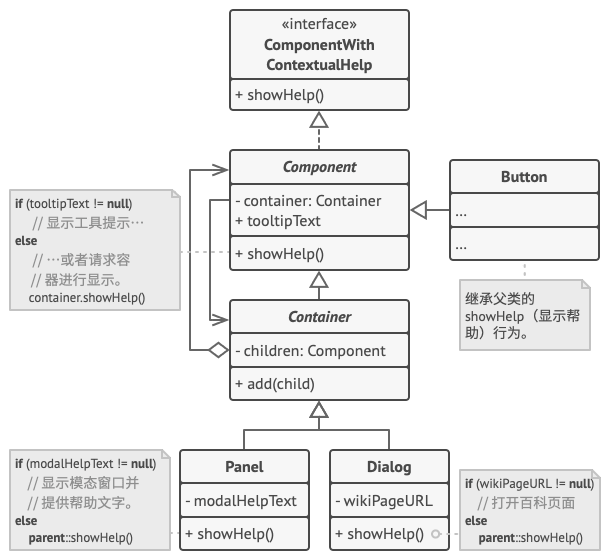

+

+

+1. **组件** (Component) 是各种包含业务逻辑的类。 每个组件都有一个指向中介者的引用, 该引用被声明为中介者接口类型。 组件不知道中介者实际所属的类, 因此可通过将其连接到不同的中介者以使其能在其他程序中复用。

+2. **中介者** (Mediator) 接口声明了与组件交流的方法, 但通常仅包括一个通知方法。 组件可将任意上下文 (包括自己的对象) 作为该方法的参数, 只有这样接收组件和发送者类之间才不会耦合。

+3. **具体中介者** (Concrete Mediator) 封装了多种组件间的关系。 具体中介者通常会保存所有组件的引用并对其进行管理, 甚至有时会对其生命周期进行管理。

+4. 组件并不知道其他组件的情况。 如果组件内发生了重要事件, 它只能通知中介者。 中介者收到通知后能轻易地确定发送者, 这或许已足以判断接下来需要触发的组件了。

+5. 对于组件来说, **中介者看上去完全就是一个黑箱。 发送者不知道最终会由谁来处理自己的请求, 接收者也不知道最初是谁发出了请求**。

+

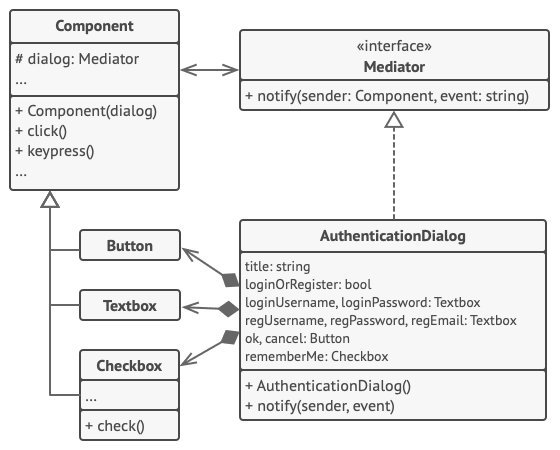

+## 6.伪代码

+

+**中介者**模式可帮助减少各种 UI 类 (按钮、 复选框和文本标签) 之间的相互依赖关系。

+

+用户触发的元素不会直接与其他元素交流, 即使看上去它们应该这样做。 相反, 元素只需让中介者知晓事件即可, 并能在发出通知时同时传递任何上下文信息。

+

+本例中的中介者是整个认证对话框。 对话框知道具体元素应如何进行合作并促进它们的间接交流。 当接收到事件通知后, 对话框会确定负责处理事件的元素并据此重定向请求。

+

+```

+// 中介者接口声明了一个能让组件将各种事件通知给中介者的方法。中介者可对这些事件做出响应并将执行工作传递给其他组件。

+interface Mediator is

+ method notify(sender: Component, event: string)

+

+// 具体中介者类要解开各组件之间相互交叉的连接关系并将其转移到中介者中。

+class AuthenticationDialog implements Mediator is

+ private field title: string

+ private field loginOrRegisterChkBx: Checkbox

+ private field loginUsername, loginPassword: Textbox

+ private field registrationUsername, registrationPassword,

+ registrationEmail: Textbox

+ private field okBtn, cancelBtn: Button

+ constructor AuthenticationDialog() is

+ // 创建所有组件对象并将当前中介者传递给其构造函数以建立连接。

+ // 当组件中有事件发生时,它会通知中介者。中介者接收到通知后可自行处理也可将请求传递给另一个组件。

+ method notify(sender, event) is

+ if (sender == loginOrRegisterChkBx and event == "check")

+ if (loginOrRegisterChkBx.checked)

+ title = "登录"

+ // 1. 显示登录表单组件。

+ // 2. 隐藏注册表单组件。

+ else

+ title = "注册"

+ // 1. 显示注册表单组件。

+ // 2. 隐藏登录表单组件。

+

+ if (sender == okBtn && event == "click")

+ if (loginOrRegister.checked)

+ // 尝试找到使用登录信息的用户。

+ if (!found)

+ // 在登录字段上方显示错误信息。

+ else

+ // 1. 使用注册字段中的数据创建用户账号。

+ // 2. 完成用户登录工作。 …

+

+ class Component is

+ field dialog: Mediator

+ constructor Component(dialog) is

+ this.dialog = dialog

+ method click() is

+ dialog.notify(this, "click")

+ method keypress() is

+ dialog.notify(this, "keypress")

+

+ // 具体组件之间无法进行交流。它们只有一个交流渠道,那就是向中介者发送通知。

+class Button extends Component is

+ // ...

+

+class Textbox extends Component is

+ // ...

+

+class Checkbox extends Component is

+ method check() is

+ dialog.notify(this, "check")

+ // ...

+

+

+```

+

+- 当一些对象和其他对象紧密耦合以致难以对其进行修改时, 可使用中介者模式。

+

+ 该模式让将对象间的所有关系抽取成为一个单独的类, 以使对于特定组件的修改工作独立于其他组件。

+

+- 当组件因过于依赖其他组件而无法在不同应用中复用时,可使用中介者模式

+

+ 应用中介者模式后, 每个组件不再知晓其他组件的情况。 尽管这些组件无法直接交流, 但它们仍可通过中介者对象进行间接交流。 如果希望在不同应用中复用一个组件, 则需要为其提供一个新的中介者类。

+

+- 如果为了能在不同情景下复用一些基本行为,导致需要被迫创建大量组件子类时,可使用中介者模式。

+

+- 由于所有组件间关系都被包含在中介者中, 因此无需修改组件就能方便地新建中介者类以定义新的组件合作方式。

+

+## 7.实现

+

+1. 找到一组当前紧密耦合, 且提供其独立性能带来更大好处的类 (例如更易于维护或更方便复用)。

+2. 声明中介者接口并描述中介者和各种组件之间所需的交流接口。 在绝大多数情况下, 一个接收组件通知的方法就足够了。

+3. 如果希望在不同情景下复用组件类, 那么该接口将非常重要。 只要组件使用通用接口与其中介者合作, 就能将该组件与不同实现中的中介者进行连接。

+4. 实现具体中介者类。 该类可从自行保存其下所有组件的引用中受益。

+5. 可以更进一步, 让中介者负责组件对象的创建和销毁。 此后, 中介者可能会与工厂或外观模式类似。

+6. 组件必须保存对于中介者对象的引用。 该连接通常在组件的构造函数中建立, 该函数会将中介者对象作为参数传递。

+7. 修改组件代码, 使其可调用中介者的通知方法, 而非**其他组件**的方法。 然后将调用其他组件的代码抽取到中介者类中, 并在**中介者**接收到该组件通知时**执行**这些**代码**。(中介者执行调用其他组件代码的逻辑)

+

+.

\ No newline at end of file

diff --git a/_posts/2020-02-28-sample-markdown.md b/_posts/2020-02-28-sample-markdown.md

deleted file mode 100644

index 6a59d6a14aac..000000000000

--- a/_posts/2020-02-28-sample-markdown.md

+++ /dev/null

@@ -1,95 +0,0 @@

----

-layout: post

-title: Sample blog post to learn markdown tips

-subtitle: There's lots to learn!

-gh-repo: daattali/beautiful-jekyll

-gh-badge: [star, fork, follow]

-tags: [test]

-comments: true

-mathjax: true

-author: Bill Smith

----

-

-{: .box-success}

-This is a demo post to show you how to write blog posts with markdown. I strongly encourage you to [take 5 minutes to learn how to write in markdown](https://markdowntutorial.com/) - it'll teach you how to transform regular text into bold/italics/tables/etc.

I also encourage you to look at the [code that created this post](https://raw.githubusercontent.com/daattali/beautiful-jekyll/master/_posts/2020-02-28-sample-markdown.md) to learn some more advanced tips about using markdown in Beautiful Jekyll.

-

-**Here is some bold text**

-

-## Here is a secondary heading

-

-[This is a link to a different site](https://deanattali.com/) and [this is a link to a section inside this page](#local-urls).

-

-Here's a table:

-

-| Number | Next number | Previous number |

-| :------ |:--- | :--- |

-| Five | Six | Four |

-| Ten | Eleven | Nine |

-| Seven | Eight | Six |

-| Two | Three | One |

-

-You can use [MathJax](https://www.mathjax.org/) to write LaTeX expressions. For example:

-When \\(a \ne 0\\), there are two solutions to \\(ax^2 + bx + c = 0\\) and they are $$x = {-b \pm \sqrt{b^2-4ac} \over 2a}.$$

-

-How about a yummy crepe?

-

-

-

-It can also be centered!

-

-{: .mx-auto.d-block :}

-

-Here's a code chunk:

-

-~~~

-var foo = function(x) {

- return(x + 5);

-}

-foo(3)

-~~~

-

-And here is the same code with syntax highlighting:

-

-```javascript

-var foo = function(x) {

- return(x + 5);

-}

-foo(3)

-```

-

-And here is the same code yet again but with line numbers:

-

-{% highlight javascript linenos %}

-var foo = function(x) {

- return(x + 5);

-}

-foo(3)

-{% endhighlight %}

-

-## Boxes

-You can add notification, warning and error boxes like this:

-

-### Notification

-

-{: .box-note}

-**Note:** This is a notification box.

-

-### Warning

-

-{: .box-warning}

-**Warning:** This is a warning box.

-

-### Error

-

-{: .box-error}

-**Error:** This is an error box.

-

-## Local URLs in project sites {#local-urls}

-

-When hosting a *project site* on GitHub Pages (for example, `https://USERNAME.github.io/MyProject`), URLs that begin with `/` and refer to local files may not work correctly due to how the root URL (`/`) is interpreted by GitHub Pages. You can read more about it [in the FAQ](https://beautifuljekyll.com/faq/#links-in-project-page). To demonstrate the issue, the following local image will be broken **if your site is a project site:**

-

-

-

-If the above image is broken, then you'll need to follow the instructions [in the FAQ](https://beautifuljekyll.com/faq/#links-in-project-page). Here is proof that it can be fixed:

-

-

diff --git a/_posts/2020-02-28-test-markdown.md b/_posts/2020-02-28-test-markdown.md

new file mode 100644

index 000000000000..0eaaaec97a6f

--- /dev/null

+++ b/_posts/2020-02-28-test-markdown.md

@@ -0,0 +1,185 @@

+---

+layout: post

+title: Go中单例模式的安全性

+subtitle: golang

+tags: [设计模式]

+comments: true

+---

+

+# 浅谈Go中单例模式的安全性

+

+## 1.常见错误

+

+不考虑线程安全的单例实现

+

+```go

+package singleton

+

+type singleton struct {

+}

+

+var instance *singleton

+

+func GetInstance() *singleton {

+ if instance == nil {

+ instance = &singleton{} // <--- NOT THREAD SAFE

+ }

+ return instance

+}

+```

+

+在上述场景中,多个 go 例程可以评估第一次检查,它们都将创建该`singleton`类型的实例并相互覆盖。无法保证这里会返回哪个实例,这不好的原因是,如果通过代码保留对单例实例的引用,则可能存在具有不同状态的类型的多个实例,从而产生潜在的不同代码行为。在调试时,由于运行时暂停,没有什么真正出现错误,最大限度地减少了非线程安全执行的可能性,很容易隐藏开发的问题。

+

+## 2.Aggressive Locking

+

+### 激进的锁定

+

+```go

+var mu Sync.Mutex

+

+func GetInstance() *singleton {

+ mu.Lock() // <--- Unnecessary locking if instance already created

+ defer mu.Unlock()

+

+ if instance == nil {

+ instance = &singleton{}

+ }

+ return instance

+}

+```

+

+实际上,这解决了线程安全问题,但会产生其他潜在的严重问题。我们通过`Sync.Mutex`在创建单例实例之前引入并获取锁来解决线程安全问题。问题是在这里我们执行了过多的锁定,即使我们不需要这样做,**如果实例已经创建并且我们应该简单地返回缓存的单例实例。** 高度并发的代码库上,这可能会产生瓶颈,因为一次只有一个 go 例程可以获取单例实例。

+

+- **当某个函数,执行的功能,第一次创建一个单例,之后要做的仅仅是返回这个单例时,如果为单例的第一次创建加了锁,这么做是为了保证,第一次全局我们只能获取到一个单例,但是,之后的每一次调用,我们的函数要做的仅仅是返回这个单例,而加锁,导致的后果是每次只有一个进程可以获取到已经存在的单例,如果这种获取是百万并发级别的,那么后果是不堪设想的。**

+

+## 3.Check-Lock-Check Pattern

+

+```go

+if check() {

+ lock() {

+ if check() {

+ // perform your lock-safe code here

+ }

+ }

+}

+```

+

+在 C++ 和其他语言中,确保最小锁定并且仍然是线程安全的最好和最安全的方法是在获取锁时使用称为 Check-Lock-Check 的众所周知的模式。这种模式背后的想法是,需要先进行检查,以尽量减少任何**激进的锁定**,(开销非常大的锁定)因为 **IF 语句比锁定更便宜**。其次,我们希望等待并获取排他锁,因此一次只有一个执行在该块内。但是在第一次检查和获得排他锁之前,可能有另一个线程确实获得了锁,因此我们需要再次检查锁内部以避免用另一个实例替换实例。

+

+如果我们将这种模式应用到我们的`GetInstance()`方法中,我们将得到如下内容:

+

+```

+func GetInstance() *singleton {

+ if instance == nil { // <-- Not yet perfect. since it's not fully atomic

+ mu.Lock()

+ defer mu.Unlock()

+

+ if instance == nil {

+ instance = &singleton{}

+ }

+ }

+ return instance

+}

+```

+

+这是一种更好的方法,但仍然**不**完美。由于由于编译器优化,没有对实例存储状态进行原子检查。考虑到所有的技术因素,这仍然不是完美的。但它比最初的方法要好得多。但是使用该`sync/atomic`包,我们可以自动加载并设置一个标志,该标志将指示我们是否已初始化我们的实例。

+

+```

+import "sync"

+import "sync/atomic"

+

+var initialized uint32

+...

+

+func GetInstance() *singleton {

+

+ if atomic.LoadUInt32(&initialized) == 1 {

+ return instance

+ }

+

+ mu.Lock()

+ defer mu.Unlock()

+

+ if initialized == 0 {

+ instance = &singleton{}

+ atomic.StoreUint32(&initialized, 1)

+ }

+

+ return instance

+}

+```

+

+## 4.Go 中惯用的单例方法

+

+```

+// Once is an object that will perform exactly one action.

+type Once struct {

+ m Mutex

+ done uint32

+}

+

+// Do calls the function f if and only if Do is being called for the

+// first time for this instance of Once. In other words, given

+// var once Once

+// if once.Do(f) is called multiple times, only the first call will invoke f,

+// even if f has a different value in each invocation. A new instance of

+// Once is required for each function to execute.

+//

+// Do is intended for initialization that must be run exactly once. Since f

+// is niladic, it may be necessary to use a function literal to capture the

+// arguments to a function to be invoked by Do:

+// config.once.Do(func() { config.init(filename) })

+//

+// Because no call to Do returns until the one call to f returns, if f causes

+// Do to be called, it will deadlock.

+//

+// If f panics, Do considers it to have returned; future calls of Do return

+// without calling f.

+//

+func (o *Once) Do(f func()) {

+ if atomic.LoadUint32(&o.done) == 1 { // <-- Check

+ return

+ }

+ // Slow-path.

+ o.m.Lock() // <-- Lock

+ defer o.m.Unlock()

+ if o.done == 0 { // <-- Check

+ defer atomic.StoreUint32(&o.done, 1)

+ f()

+ }

+}

+```

+

+这意味着我们可以利用很棒的 Go 同步包只调用一次方法。因此,我们可以这样调用该`once.Do()`方法:

+

+```

+once.Do(func() {

+ // perform safe initialization here

+})

+//利用sync.Once类型来同步对 的访问,GetInstance()并确保我们的类型只被初始化一次。

+```

+

+```

+package singleton

+

+import (

+ "sync"

+)

+

+type singleton struct {

+}

+

+var instance *singleton

+var once sync.Once

+

+func GetInstance() *singleton {

+ once.Do(func() {

+ instance = &singleton{}

+ })

+ return instance

+}

+```

+

+因此,使用`sync.Once`包是安全实现这一点的首选方式,类似于 Objective-C 和 Swift (Cocoa) 实现`dispatch_once`方法来执行类似的初始化。

+

+

diff --git a/_posts/2020-06-15-test-markdown.md b/_posts/2020-06-15-test-markdown.md

new file mode 100644

index 000000000000..5dfcd7a43e72

--- /dev/null

+++ b/_posts/2020-06-15-test-markdown.md

@@ -0,0 +1,67 @@

+---

+layout: post

+title: Go值拷贝的理解

+subtitle: In a function call, the function value and arguments are evaluated in the usual order. After they are evaluated, the parameters of the call are passed by value to the function and the called function begins execution.

+tags: [golang]

+---

+# Go值拷贝的理解

+

+> In a function call, the function value and arguments are evaluated in the usual order. After they are evaluated, the parameters of the call are passed by value to the function and the called function begins execution.

+

+官方文档已经明确说明:Go里边函数传参只有值传递一种方式: 值传递

+那么为什么还会有有关Go的值拷贝的思考?

+

+```

+package main

+

+import (

+ "fmt"

+)

+

+func main() {

+ arr := [5]int{0, 1, 2, 3, 4}

+ s := arr[1:]

+ changeSlice(s)

+ fmt.Println(s)

+ fmt.Println(arr)

+}

+

+func changeSlice(arr []int) {

+ for i := range arr {

+ arr[i] = 10

+ }

+}

+

+

+Output:

+[10 10 10 10]

+[0 10 10 10 10]

+```

+

+如果Go是值拷贝的,那么我修改了函数 `changeSlice` 里面的`slice s` 的值,为什么main函数里面的`slice`和 `array`也被修改了

+

+以上图为例,a 是初始变量,b 是引用变量(Go中并不存在),p 是指针变量,

+

+在这里变量a被拷贝后,地址发生了变化,地址上存储的是原先地址存储的值 10 变量p被拷贝后,地址发生了变化,地址上存储的还是原先地址存储的值 )0X001, 然后按照这个地址去查找,找到的是 0X001 上面存储的值

+

+所以,当去修改拷贝后的*p的值,其实修改的还是0X001地址上的值,而不是 拷贝后a的值

+

+> 怎么理解呢?就是对于切片的底层数据而言,其中三个 要素。类型,容量,指针,指针是用来干嘛的,就是指向数组啊,所以说,不论怎么拷贝切片,切片的指针都是指向原来的数组,当修改切片的值时,其实是在修改数组的值!!!!

+

+**slice在实现的时候,其实是对array的映射,也就是说slice存对应的是原array的地址,就类似于p与a的关系,那么整个slice拷贝后,拷贝后的slice中存储的还是array的地址,去修改拷贝后的slice,其实跟修改slice,和原array是一样的**

+

+**上面这句话很很很重要,要记住的是: 1.切片是对数组的映射,相当于是数组a和指向a的指针 2.不论对切片的拷贝是什么样的?切片的底层数据的指针都是指向数组的。去修改切片的值就是修改数组的值。**

+

+

+

+

+

+#### 总结:

+

+> go 值的拷贝都是值拷贝,只是切片中储存的是原数组的地址,“切片是对数组的引用” 每得到的一个切片都是一个指向数组的指针,当企图修改切片的值,就是在修改数组的值。内在的逻辑是:一个切片就是一个指向数组的指针,通过切片去修改数组,然后在引用数组,自始至终,都是在引用数组,不存在切片里面存了所引用的数组的数据!!!

+

+

+

+> Go的拷贝都是值拷贝,只是slice中存储的是原array的地址,所以在拷贝的时候,其实是把地址拷贝的新的slice,那么此时修改slice的时候,还是根据slice中存储的地址,找到要修改的内容

+

+

diff --git a/_posts/2021-02-28-test-markdown.md b/_posts/2021-02-28-test-markdown.md

new file mode 100644

index 000000000000..00787806022a

--- /dev/null

+++ b/_posts/2021-02-28-test-markdown.md

@@ -0,0 +1,105 @@

+---

+layout: post

+title: 远程分支有更新,如何同步?

+subtitle:

+tags: [git]

+---

+

+## 首先同步远程的仓库和远程 fork 的仓库

+

+在 github 上找到 fork 到自己主页的仓库,然后点击`Sync fork`

+

+## 其次本地仓库和自己主页的仓库

+

+然后在本地切换到 master 分支后

+

+```shell

+git fetch --all

+```

+

+```shell

+git reset --hard origin/master

+```

+

+```shell

+git pull

+```

+

+Tips:

+**git fetch 只是下载远程的库的内容,不做任何的合并**

+

+**git reset 把 HEAD 指向刚刚下载的最新的版本**

+

+## 第三就是同步本地仓库的其他分支和本地仓库的 master 分支

+

+然后在本地切换到 master 分支后,(在记得切换到 master 分支后,先要在其他的分支保存自己的更改)

+在 my-feature7 分支执行:

+

+```shell

+git add .

+```

+

+在 my-feature7 分支执行:

+

+```shell

+git commit -m"fix:"

+```

+

+```shell

+git pull

+```

+

+然后在本地切换到想要更新的其他分支

+

+```shell

+git checkout my-feature7

+```

+

+然后合并

+

+```shell

+git merge master

+```

+

+然后在 my-feature7 分支做出修改,提交到远程的 my-feature7 分支后提交 pr

+

+```shell

+git add newfile.go

+```

+

+```shell

+git commit -m"fix:555"

+```

+

+```shell

+git push origin my-feature7

+```

+

+

+## 常见问题

+

+当你在本地有更改,但是想丢弃所有的这些更改的时候:

+

+首先,需要处理当前分支(feat_shard_join)上的未暂存的更改。有几个选项:

+

+提交这些更改:

+```shell

+git add -A && git commit -m "你的提交信息"

+```

+撤销这些更改:

+```shell

+git restore .

+```

+确保所有的更改已处理后,你可以切换到 develop 分支:

+

+```shell

+git checkout develop

+```

+同步远程的 develop 分支更新到你的本地:

+

+```shell

+git pull origin develop

+```

+这样,你就成功切换到了 develop 分支并与远程仓库同步。请注意,在执行这些操作之前最好备份你的代码,以防意外发生。

+

+

diff --git a/_posts/2021-11-20-test-markdown.md b/_posts/2021-11-20-test-markdown.md

new file mode 100644

index 000000000000..5d5cbbc215ac

--- /dev/null

+++ b/_posts/2021-11-20-test-markdown.md

@@ -0,0 +1,88 @@

+---

+layout: post

+title: 并发一致性问题

+subtitle: 在并发环境下,事务的隔离性很难保证,因此会出现很多并发一致性问题。

+tags: [数据库]

+---

+

+## 并发一致性问题

+

+在并发环境下,事务的隔离性很难保证,因此会出现很多并发一致性问题。

+

+### 丢失修改

+

+丢失修改指一个事务的更新操作被另外一个事务的更新操作替换。一般在现实生活中常会遇到,例如:T1 和 T2 两个事务都对一个数据进行修改,T1 先修改并提交生效,T2 随后修改,T2 的修改覆盖了 T1 的修改。

+

+> 丢失修改(Lost Update):假设有两个用户A和B同时对数据库中的某一数据进行修改,并且A先提交了修改,然后B也提交了修改,那么A的修改就会被B的修改覆盖,从而导致A的修改丢失。例如,A和B同时对某一商品的库存进行修改,A将库存从100减少到90并提交了修改,然后B也将库存从100减少到95并提交了修改,那么最终库存会变成95而不是90。

+

+

+### 读脏数据

+

+读脏数据指在不同的事务下,当前事务可以读到另外事务未提交的数据。例如:T1 修改一个数据但未提交,T2 随后读取这个数据。如果 T1 撤销了这次修改,那么 T2 读取的数据是脏数据

+

+> 读脏数据(Dirty Read):假设有一个用户A对数据库中的某一数据进行修改,并且在修改过程中,另一个用户B对该数据进行了查询,那么B就可能会读到未提交的“脏数据”,从而导致数据的不一致性。例如,A对某一商品的价格进行修改,将价格从100元增加到120元,但是还没有提交修改,此时B查询该商品的价格时,发现价格已经变成了120元,但是实际上A的修改还没有提交,因此B读到了未提交的“脏数据”。

+

+

+### 不可重复读

+

+不可重复读指在一个事务内多次读取同一数据集合。在这一事务还未结束前,另一事务也访问了该同一数据集合并做了修改,由于第二个事务的修改,第一次事务的两次读取的数据可能不一致。例如:T2 读取一个数据,T1 对该数据做了修改。如果 T2 再次读取这个数据,此时读取的结果和第一次读取的结果不同。

+

+

+

+产生并发不一致性问题的主要原因是破坏了事务的隔离性,解决方法是通过并发控制来保证隔离性。并发控制可以通过封锁来实现,但是封锁操作需要用户自己控制,相当复杂。数据库管理系统提供了事务的隔离级别,让用户以一种更轻松的方式处理并发一致性问题。

+

+

+> 不可重复读(Non-repeatable Read):假设有一个用户A对数据库中的某一数据进行查询,并且在查询过程中,另一个用户B对该数据进行了修改,那么A再次查询该数据时就会发现数据与之前不一致。例如,A查询某一商品的价格为100元,然后B将该商品的价格修改为110元,并提交了修改,此时A再次查询该商品的价格时,发现价格已经变成了110元,与之前不一致。

+

+### 解决该问题

+

+

+> 丢失修改:由于事务在修改数据R之前必须加上X锁,其他事务无法同时修改R,因此可以避免丢失修改的问题。

+

+> 不可重复读:由于事务在读取数据R之前必须加上S锁,其他事务无法同时修改或删除R,因此可以避免不可重复读的问题

+

+> 读脏数据:由于事务在读取数据R之前必须加上S锁,其他事务无法同时修改或删除R,因此可以避免读脏数据的问题。

+

+

+存在的问题:缺点是锁的粒度较大,可能会导致资源的浪费和性能的下降

+

+## 两段封锁协议

+

+两段封锁协议是一种并发控制方法,它要求事务必须分两个阶段对数据项进行加锁和解锁操作。这两个阶段分别是封锁阶段和解封锁阶段,具体如下:

+

+封锁阶段:在该阶段中,事务可以获得任何数据项上的任何类型的锁,但不能释放锁。在该阶段,事务需要先获得所有需要使用的锁,然后才能进行相应的操作,例如读取或修改数据。该阶段的目的是保证在事务对数据进行操作时,其他事务无法修改或删除数据,从而避免数据不一致的情况。

+

+解封锁阶段:在该阶段中,事务可以释放任何数据项上的任何类型的锁,但不能申请新的锁。在该阶段,事务需要先释放所有不再需要使用的锁,然后才能提交事务或者回滚事务。该阶段的目的是释放事务在该阶段中,事务可以释放任何数据项上的任何类型的锁,但不能申请新的锁。在该阶段,事务需要先释放所有不再需要使用的锁,然后才能提交事务或者回滚事务。该阶段的目的是释放事务占用的资源,避免资源的浪费。

+

+

+## 死锁/活锁

+

+活锁是指在并发访问的过程中,由于某些原因,事务一直处于等待状态,但是等待的条件不满足,导致事务无法继续执行。例如,在两个事务同时请求封锁同一条数据时,如果它们始终无法获取到该数据的封锁,就会导致活锁的情况发生。在活锁的情况下,事务一直在运行,但是无法完成任务,导致系统资源的浪费和性能的下降。

+

+死锁是指在并发访问的过程中,由于多个事务之间相互等待对方持有的锁,导致多个事务都无法继续执行,从而形成了一个死循环。例如,如果事务A请求封锁数据R1后又请求封锁数据R2,而事务B则请求封锁数据R2后又请求封锁数据R1,这样就会导致事务A和事务B之间形成了一个死锁。在死锁的情况下,事务都无法继续执行,只能等待其他事务释放锁,从而导致系统的资源浪费和性能下降。

+

+

+> 封锁协议可以解决死锁的问题,封锁协议可以通过以下两种方式来避免死锁的情况:

+

+- 顺序加锁:在多个事务同时访问多个数据项时,按照固定的顺序对数据项进行加锁,从而避免不同事务之间加锁的顺序不一致,导致死锁的情况发生。

+

+- 封锁超时:如果一个事务不能在规定的时间内获得所需的锁,就会取消该事务的请求,从而避免死锁的情况发生。在这种情况下,事务需要在等待锁的过程中,不断地检查是否超时,如果超时,则可以回滚事务,释放已经获得的锁。

+

+

+## 并发调度的可串行化

+

+并发调度是指在多个事务同时访问共享资源的情况下,如何安排这些事务的执行顺序,以保证系统的正确性和性能。可串行性是并发调度的一个重要准则,它指的是多个事务的并发执行结果与某一次序串行地执行这些事务时的结果相同。

+

+举个例子,假设有两个事务T1和T2,它们要同时访问数据R1和R2。如果这两个事务的执行顺序是T1访问R1,然后T2访问R2,最后T1访问R2,T2访问R1,那么这个调度是可串行化的,因为将这两个事务按照顺序串行地执行,也会得到相同的结果。如果这个调度不是可串行化的,例如T1和T2同时访问R1和R2,那么这个调度就是不正确的,因为它可能导致数据的错误或者不一致。

+

+要实现可串行化的调度,需要采用一些并发控制方法,例如加锁、封锁协议、事务隔离级别等。其中,加锁是最基本的并发控制方法,并且可以有效地避免并发访问的冲突。封锁协议可以保证事务的一致性和可串行性,从而避免数据的不一致和错误。事务隔离级别可以控制事务之间的相互影响,从而保证事务的独立性和正确性。

+

+### 实现并发调度的可串行化

+

+加锁:采用锁机制来控制事务之间的访问顺序和互斥访问,从而保证事务的正确性和一致性。一般来说,加锁的粒度越小,锁的争用就越少,但是也会带来更多的锁开销。

+

+封锁协议:通过规定事务加锁的顺序,避免出现事务之间的死锁和活锁的情况,从而保证事务的可串行性和正确性。封锁协议有很多种,如二段锁、多粒度锁等。

+

+事务隔离级别:事务隔离级别可以控制事务之间的相互影响,从而保证事务的独立性和正确性。一般来说,事务隔离级别越高,事务之间的相互影响就越小,但是也会带来更多的性能开销。

+

+MVCC(多版本并发控制):采用多版本的方式来控制并发访问,从而保证事务的可串行性和正确性。MVCC可以避免一些常见的并发问题,例如脏读、不可重复读和幻读等

\ No newline at end of file

diff --git a/_posts/2021-12-30-test-markdown.md b/_posts/2021-12-30-test-markdown.md

new file mode 100644

index 000000000000..fb11f6376c14

--- /dev/null

+++ b/_posts/2021-12-30-test-markdown.md

@@ -0,0 +1,254 @@

+---

+layout: post

+title: 并发工作者池模式

+subtitle: 并不是要讨论并发,而是我们要实现一组作业如何让他并发的执行

+tags: [并发]

+---

+# Go Concurrency Worker Pool PatternGo 并发工作者池模式

+

+> 并不是要讨论并发,而是我们要实现一组作业如何让他并发的执行

+

+## **WorkerPool 组件编排**

+

+

+

+### 1.**第一步**

+

+```

+// 创建了一个名为 的最小工作单元Job

+type Job struct {

+ Descriptor JobDescriptor

+ ExecFn ExecutionFn

+ Args interface{}

+}

+

+// ExecutionFn 是这个函数类型 func ( ctx context.Context, args interface{})(value ,error)

+// 可以看到函数返回了一个value类型 和 error类型

+// 我们自己定义一个 Result 类型来存储Job的方法对应的信息

+和里面存储 Job.Descriptor 类型是JobDescriptor

+// 还存储了 Job.ExecFn函数执行得到的错误的信息

+type Result struct{

+ //Err字段来存储Job.ExecFn函数执行的结果中的Error

+ Err error

+ //Value字段来存储Job.ExecFn函数执行的结果中的value 类型

+ Value value

+ //Descriptor字段来存储Job这个结构体自己带的Descriptor描述信息

+ Descriptor JobDescriptor

+}

+//执行函数最简单的逻辑就是得到结果

+func (j Job) execute(ctx context.Context) Result {

+ value, err := j.ExecFn(ctx, j.Args)

+ if err != nil {

+ return Result{

+ Err: err,

+ Descriptor: j.Descriptor,

+ }

+ }

+

+ return Result{

+ Value: value,

+ Descriptor: j.Descriptor,

+ }

+}

+```

+

+### 2.第二步

+

+```

+//我们要使用generator并发模式将所有Jobs 流式传输到WorkerPool.

+

+//说人话就是......

+//从某个客户端定义Job的 s 切片上生成一个流,将它们中的每一个推入一个通道,即Jobs 通道。这将用于同时馈送WorkerPool.

+//所以客户端定义Job的 s 切片在哪里?

+//忘了在前面加了...

+//补充完毕之后完整的代码应该是下面这个样子

+//map[string]interface{} string 用来代表不同的客户端 (为了便于处理)具体客户端携带的东西可以是任何的东西

+

+type jobMetadata map[string]interface{}

+type Job struct {

+ Descriptor JobDescriptor

+ ExecFn ExecutionFn

+ Args interface{}

+}

+

+type Result struct{

+ //Err字段来存储Job.ExecFn函数执行的结果中的Error

+ Err error

+ //Value字段来存储Job.ExecFn函数执行的结果中的value 类型

+ Value value

+ //Descriptor字段来存储Job这个结构体自己带的Descriptor描述信息

+ Descriptor JobDescriptor

+}

+

+func (j Job) execute(ctx context.Context) Result {

+ value, err := j.ExecFn(ctx, j.Args)

+ if err != nil {

+ return Result{

+ Err: err,

+ Descriptor: j.Descriptor,

+ }

+ }

+

+ return Result{

+ Value: value,

+ Descriptor: j.Descriptor,

+ }

+}

+

+```

+

+```

+// 当然要写个函数喽,来把我们客户端的工作全部推入到 Jobs 通道

+// func GenerateFrom( jobsBulk []Job )

+// 这个函数应该是属于 Jobs 通道的 ,我们当然要抽象出来一个 Jobs 通道

+// WorkerPool 就是我们抽象出来的一个结构体

+// WorkerPool 里面有个字段 jobs

+// WorkerPool.jobs应该是一个通道

+// 我们把我们的[]Job 切片依次放到这个通道里面

+// 然后关闭通道

+func (wp WorkerPool) GenerateFrom(jobsBulk []Job) {

+ for i, _ := range jobsBulk {

+ wp.jobs <- jobsBulk[i]

+ }

+ close(wp.jobs)

+}

+

+// WorkerPool.jobs是一个缓冲通道(workers count capped的大小)WorkerPool.workersCount 这个

+

+// 一旦它被填满,任何进一步的写入尝试都会阻塞当前的 goroutine

+// 在这种情况下,流的生成器 goroutine 从 1 开始)

+// 在任何时候,如果WorkerPool.jobs通道上存在任何内容,将被Worker函数消耗以供以后执行。通过这种方式,通道将为从前一点Job流出的新写入解除阻塞。generator

+```

+

+### 3.第三步**WorkerPool**

+

+```

+// workersCount 字段

+// jobs 字段 工人自己将负责在channel可用时从channel中获取Job

+// 从 jobs channel中提取所有可用的作业后,WorkerPool 将通过关闭自己的 Done channel 和 Results channel来完成其执行。

+// results 字段 工人执行Job并将其Result存储到Result的channel

+// 只要没有在 Context 上调用 cancel() 函数,Worker 就会执行前面提到的操作。

+// Done 字段

+// 否则,循环制动,WaitGroup 被标记为 Done()。这与“杀死工人”的想法非常相似。

+type WorkerPool struct{

+ workersCount int

+ jobs chan Job

+ results chan Result

+ Done chan struct{}

+}

+//工人自己将负责在channe可用时从channe中获取Job

+

+func worker(ctx context.Context, wg *sync.WaitGroup, jobs <-chan Job, results chan<- Result) {

+ defer wg.Done()

+ for {

+ select {

+ case job, ok := <-jobs:

+ if !ok {

+ return

+ }

+ // fan-in job execution multiplexing results into the results channel

+ //执行多路复用结果到结果通道

+ results <- job.execute(ctx)

+ case <-ctx.Done():

+ fmt.Printf("cancelled worker. Error detail: %v\n", ctx.Err())

+ results <- Result{

+ Err: ctx.Err(),

+ }

+ return

+ }

+ }

+}

+

+func New(wcount int) WorkerPool {

+ return WorkerPool{

+ workersCount: wcount,

+ jobs: make(chan Job, wcount),

+ results: make(chan Result, wcount),

+ Done: make(chan struct{}),

+ }

+}

+

+

+

+func (wp WorkerPool) Run(ctx context.Context) {

+ var wg sync.WaitGroup

+

+ for i := 0; i < wp.workersCount; i++ {

+ wg.Add(1)

+ // fan out worker goroutines

+ //reading from jobs channel and

+ //pushing calcs into results channel

+ go worker(ctx, &wg, wp.jobs, wp.results)

+ }

+

+ wg.Wait()

+ close(wp.Done)

+ close(wp.results)

+}

+```

+

+### 4.第四步Results Channel

+

+如前所述,即使工作人员在不同的 goroutine 上运行,他们也会通过将它们多路复用到' 通道(AKA ***fanning-in\***`Job` )来发布' 执行。即使通道因上述任何原因关闭,客户端也可以从此源读取。`Result``Result``WorkerPool`

+

+### 5. Reading Results

+

+如前所述,即使工人在不同的 goroutine 上运行,他们通过将 Job 的执行结果多路复用到 Result 的通道(AKA fanning-in)来发布作业的执行结果。即使通道因上述任何原因关闭,WorkerPool 的客户端也可以从此源读取。

+

+一旦关闭 WorkerPool 的 Done 通道返回并向前移动,for 循环就会中断。

+

+```

+func TestWorkerPool(t *testing.T) {

+ wp := New(workerCount)

+

+ ctx, cancel := context.WithCancel(context.TODO())

+ defer cancel()

+

+ go wp.GenerateFrom(testJobs())

+

+ go wp.Run(ctx)

+

+ for {

+ select {

+ case r, ok := <-wp.Results():

+ if !ok {

+ continue

+ }

+

+ i, err := strconv.ParseInt(string(r.Descriptor.ID), 10, 64)

+ if err != nil {

+ t.Fatalf("unexpected error: %v", err)

+ }

+

+ val := r.Value.(int)

+ if val != int(i)*2 {

+ t.Fatalf("wrong value %v; expected %v", val, int(i)*2)

+ }

+ case <-wp.Done:

+ return

+ default:

+ }

+ }

+}

+```

+

+### 6.Cancel Gracefully

+

+无论如何,如果客户端需要优雅地关闭 WorkerPool 的执行,它可以在给定的 Context 上调用 cancel() 函数,或者配置由 Context.WithTimeout 方法定义的超时持续时间。

+

+是否发生一个或其他选项(最终都调用 cancel() 函数,一个显式调用,另一个在超时发生后)将从 Context 返回一个关闭的 Done 通道,该通道将传播到所有 Worker 函数

+

+这使得 for select 循环中断,因此工人停止在通道外消费作业。然后稍后,WaitGroup 被标记为完成。但是,运行中的工作人员将在 WorkerPool 关闭之前完成他们的工作执行。

+

+### 7.Sum Up

+

+当我们利用这种模式时,我们将利用我们的系统实现并发作业执行,从而在作业执行中提高性能和一致性。

+

+乍一看,这种模式可能很难掌握。但是,请花点时间消化它,特别是如果您是 GoLang 并发模型的新手。

+

+可能有帮助的一件事是将通道视为管道,其中数据从一侧流向另一侧,并且可以容纳的数据量是有限的。

+

+所以如果我们想注入更多的数据,我们只需要在等待的时候先取出一些数据来为它腾出一些额外的空间

+

+另一方面,如果我们想从管道中消费,就必须有一些东西,否则,我们等到那发生。通过这种方式,我们使用这些管道在 goroutine 之间进行通信和共享数据。

+

diff --git a/_posts/2022-02-15-test-markdown.md b/_posts/2022-02-15-test-markdown.md

new file mode 100644

index 000000000000..0b158c6a28e1

--- /dev/null

+++ b/_posts/2022-02-15-test-markdown.md

@@ -0,0 +1,461 @@

+---

+layout: post

+title: 什么是 REST API?

+subtitle: RESTful API 设计规范

+tags: [架构]

+---

+## RESTful API 设计规范

+

+**从字面可以看出,他是Rest式的接口,所以我们先了解下什么是Rest**

+

+#### 什么是 REST API?

+

+REST API 也称为 RESTful API,是遵循 REST 架构规范的应用编程接口(API 或 Web API),支持与 RESTful Web 服务进行交互。REST全称 **RE**presentational **S**tate **T**ransfer。 由Roy Thomas Fielding博士在2000年于其论文 *Architectural Styles and the Design of Network-based Software Architectures* 中提出的。 是一种分布式超媒体架构风格。

+

+> #### 什么是 API?

+>

+> API 由一组定义和协议组合而成,可用于构建和集成应用软件。有时我们可以把它们当做信息提供者和信息用户之间的合同——建立消费者(呼叫)所需的内容和制作者(响应)要求的内容。例如,天气服务的 API 可指定用户提供邮编,制作者回复的答案由两部分组成,第一部分是最高温度,第二部分是最低温度。

+>

+> 换言之,如果想与计算机或系统交互以检索信息或执行某项功能,API 可帮助将需要的信息传达给该系统,使其能够理解并满足的请求。

+>

+> 可以把 API 看做是用户或客户端与他们想要的资源或 Web 服务之间的传递者。它也是企业在共享资源和信息的同时保障安全、控制和身份验证的一种方式,即确定哪些人可以访问什么内容。

+>

+> API 的另一个优势是无需了解缓存的具体信息,即如何检索资源或资源来自哪里。

+

+> #### 如何理解 REST 的含义?

+>

+> **REST 是一组架构规范,并非协议或标准。API 开发人员可以采用各种方式实施 REST。**

+>

+> 当客户端通过 RESTful API 提出请求时,它会将资源状态表述传递给请求者或终端。该信息或表述通过 HTTP 以下列某种格式传输:JSON(Javascript 对象表示法)、HTML、XLT、Python、PHP 或纯文本。JSON 是最常用的编程语言,尽管它的名字英文原意为“JavaScript 对象表示法”,但它适用于各种语言,并且人和机器都能读。

+>

+> **头和参数在 RESTful API HTTP 请求的 HTTP 方法中也很重要,因为其中包含了请求的元数据、授权、统一资源标识符(URI)、缓存、cookie 等重要标识信息。有请求头和响应头,每个头都有自己的 HTTP 连接信息和状态码。**

+

+#### **如何实现 RESTful API?**

+

+API 要被视为 RESTful API,必须遵循以下标准:

+

+- **客户端-服务器架构由客户端、服务器和资源组成,并且通过 HTTP 管理请求。**

+

+- **[无状态](https://www.redhat.com/zh/topics/cloud-native-apps/stateful-vs-stateless)客户端-服务器通信,即 get 请求间隔期间,不会存储任何客户端信息,并且每个请求都是独立的,互不关联。**客户端到服务端的所有请求必须包含了所有信息,不能够利用任何服务器存储的上下文。 这一约束可以保证绘画状态完全由客户端控制

+

+ 这一点在写一个接口的时候需要独立思考一下,如果每个请求都是独立的,互不关联的,那么他们怎么配合着实现一整套的功能,

+

+- **可缓存性数据**:可简化客户端-服务器交互。

+

+- **组件间的统一接口:使信息以标准形式传输。这要求:**

+

+ - Identification of resources 资源标识符**所请求的资源可识别并与发送给客户端的表述分离开。**

+

+ - Manipulation of resources through representations

+

+ 通过“representation”来操作资源

+

+ - Self-descriptive messages 自我描述

+

+ 客户端可通过接收的表述操作资源,因为表述包含操作所需的充足信息。返回给客户端的自描述消息包含充足的信息,能够指明客户端应该如何处理所收到的信息。

+

+ - 超文本/超媒体可用,是指在访问资源后,客户端应能够使用超链接查找其当前可采取的所有其他操作。

+

+- **组织各种类型服务器(负责安全性、负载平衡等的服务器)的分层系统会参与将请求的信息检索到对客户端不可见的层次结构中。**

+

+ 系统是分层的,客户端无法知道也不需要知道与他交互的是否是真正的终端服务器。 这也就给了系统在中间切入的可能,提高了安全性和伸缩性。

+

+ ### Resource 资源

+

+ 在了解了REST API的约束后,REST最关键的概念就是资源。 任何的信息在REST架构里都被抽象为资源:图像、文档、集合、用户,等等。 (这在某些场景是和直觉相悖的,后文会详述) REST通过资源标识符来和特定资源进行交互。

+

+ 资源在特定时间戳下的状态称之为资源表示(Resource Representation),由**数据**,**元数据**和**超链接**组成。 资源的格式由媒体类型(media type)指定。(我们熟悉的JSON即是一种方式)

+

+ 一个真正的REST API看上去就像是超文本一样。 除了数据本身以外还包含了其他客户端想了解的信息以描述自己, 比如一个典型的例子是在获取分页数据时,服务端同时还会返回页码总数以及下一页的链接。

+

+## REST vs HTTP

+

+从上面的概念我们就可以知道,REST和任何具体技术无关。 我们会认为REST就是HTTP,主要是因为HTTP是最广为流行的客户端服务端通信协议。 但是HTTP本身和REST无关,可以通过其他协议构建RESTful服务; 用HTTP构建的服务也很有可能不是RESTful的。

+

+

+

+## REST vs JSON

+

+与通信协议一样,REST与任何具体的数据格式无关。 无论用XML,JSON或是HTML,都可以构建REST服务。

+

+更进一步的,JSON甚至不是一种超媒体格式,只是一种数据格式。 比如JSON并没有定义超链接发现的行为。 真正的REST需要的是有着清楚规范的超媒体格式,比较标准的JSON-base超媒体格式有 [JSON-LD](http://www.w3.org/TR/json-ld/) 和 [HAL](http://stateless.co/hal_specification.html)

+

+**个人最想分享的部分!!!**

+

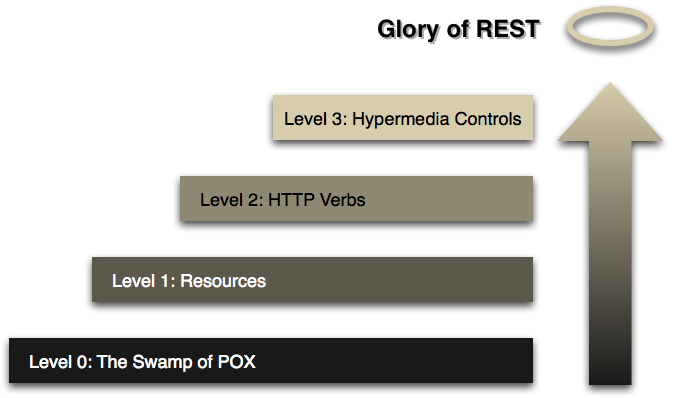

+# Richardson Maturity Model

+

+> steps toward the glory of REST

+>

+> *A model (developed by Leonard Richardson) that breaks down the principal elements of a REST approach into three steps. These introduce resources, http verbs, and hypermedia controls.*

+>

+> *一个模型(由 Leonard Richardson 开发)将 REST 方法的主要元素分解为三个步骤。这些介绍了资源、http 动词和超媒体控件。*

+

+**核心是这样一个概念,即网络是一个运行良好的大规模可扩展分布式系统的存在证明,我们可以从中汲取灵感来更轻松地构建集成系统。**

+

+*走向 REST 的步骤*

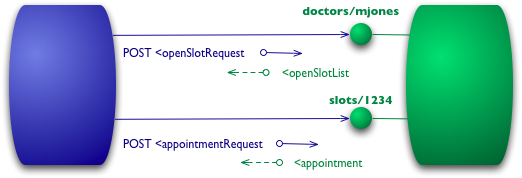

+

+

+

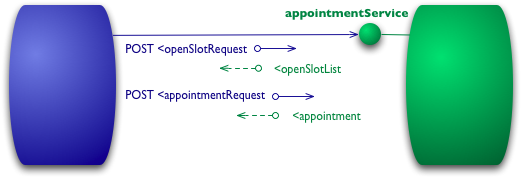

+## 级别 0

+

+该模型的出发点是使用 HTTP 作为远程交互的传输系统,但不使用任何 Web 机制。本质上,在这里所做的是使用 HTTP 作为自己的远程交互机制的隧道机制,通常基于[Remote Procedure Invocation](http://www.eaipatterns.com/EncapsulatedSynchronousIntegration.html)。

+

+

+

+*0 级交互示例*

+

+假设我想和我的医生预约。我的预约软件首先需要知道我的医生在给定日期有哪些空档,因此它会向医院预约系统发出请求以获取该信息。在 0 级场景中,医院将在某个 URI 处公开服务端点。然后,我将包含我的请求详细信息的文档发布到该端点。

+

+```

+POST /appointmentService HTTP/1.1

+[various headers]

+

+

+然后服务器将返回一个文件给我这个信息

+HTTP/1.1 200 OK

+[various headers]

+

+

+

+

+

+

+ <医生 id = "mjones"/>

+

+

+

+我在这里使用 XML 作为示例,但内容实际上可以是任何内容:JSON、YAML、键值对或任何自定义格式。

+

+我的下一步是预约,我可以再次通过将文档发布到端点来进行预约。

+POST /appointmentService HTTP/1.1

+[various headers]

+

+

+

+

+

+如果一切顺利,我会收到回复说我的约会已预订。

+HTTP/1.1 200 OK

+[various headers]

+

+

+

+

+

+如果有问题,说其他人在我之前进入,那么我会在回复正文中收到某种错误消息。

+HTTP/1.1 200 OK

+[various headers]

+

+

+

+

+ Slot not available

+

+```

+

+到目前为止,这是一个简单的 RPC 样式系统。这很简单,因为它只是来回传输普通的旧 XML (POX)。如果您使用 SOAP 或 XML-RPC,它基本上是相同的机制,唯一的区别是您将 XML 消息包装在某种信封中。

+

+## 级别 1 - 资源

+

+在 RMM 中实现REST的荣耀的第一步是引入资源。因此,现在我们不再向单个服务端点发出所有请求,而是开始与单个资源进行对话。

+

+*图 3:1 级添加资源*

+

+```

+因此,对于我们的初始查询,我们可能有给定医生的资源。

+

+POST /doctors/mjones HTTP/1.1

+[various headers]

+

+

+回复带有相同的基本信息,但现在每个插槽都是可以单独寻址的资源。

+

+HTTP/1.1 200 OK

+[various headers]

+

+

+

+

+

+

+使用特定资源预约意味着发布到特定位置。

+

+POST /slots/1234 HTTP/1.1

+[各种其他标头]

+

+

+ <患者 id = "jsmith"/>

+

+如果一切顺利,我会收到与之前类似的回复。

+

+HTTP/1.1 200 OK

+[various headers]

+

+

+

+

+

+```

+

+**区别是我们不是调用某个函数并传递参数,而是在一个特定对象上调用一个方法,为其他信息提供参数。**

+

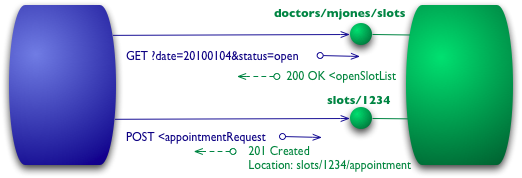

+## 第 2 级 - HTTP 动词

+

+在 0 级和 1 级的所有交互中都使用了 HTTP POST 动词,但有些人使用 GET 代替或附加使用。在这些级别上并没有太大区别,它们都被用作隧道机制,允许我们通过 HTTP 隧道交互。级别 2 远离这一点,使用 HTTP 动词尽可能接近它们在 HTTP 本身中的使用方式

+

+

+

+对于我们的插槽列表,这意味着我们要使用 GET。

+

+```

+GET /doctors/mjones/slots?date=20100104&status=open HTTP/1.1

+主机:royalhope.nhs.uk

+```

+

+回复与 POST 的回复相同

+

+```

+HTTP/1.1 200 OK

+[various headers]

+

+

+

+

+

+```

+

+在第 2 级,对这样的请求使用 GET 至关重要。HTTP 将 GET 定义为一种安全操作,即它不会对任何事物的状态进行任何重大更改。这允许我们以任何顺序安全地调用 GET 多次,并且每次都获得相同的结果。这样做的一个重要结果是,**它允许请求路由中的任何参与者使用缓存,**这是使 Web 性能与它一样好的关键因素。HTTP 包括各种支持缓存的措施,通信中的所有参与者都可以使用这些措施。通过遵循 HTTP 的规则,我们能够利用该功能。

+

+为了预约,我们需要一个改变状态的 HTTP 动词,一个 POST 或一个 PUT。我将使用与之前相同的 POST。

+

+即使我使用与级别 1 相同的帖子,远程服务的响应方式也存在另一个显着差异。如果一切顺利,该服务会回复一个响应代码 201,表示世界上有一个新资源。

+

+```

+HTTP/1.1 201 Created

+Location: slots/1234/appointment

+[various headers]

+

+

+

+

+

+

+201 响应包含一个带有 URI 的 location 属性,客户端可以使用该 URI 来获取该资源的当前状态。此处的响应还包括该资源的表示,以立即为客户端节省额外的调用。

+

+如果出现问题,例如其他人预订会话,则还有另一个区别。

+

+HTTP/1.1 409 Conflict

+[various headers]

+

+

+

+

+```

+

+此响应的重要部分是使用 HTTP 响应代码来指示出现问题。在这种情况下,409 似乎是一个不错的选择,表明其他人已经以不兼容的方式更新了资源。不是使用返回码 200 而是包含错误响应,在第 2 级,我们明确地使用了类似这样的某种错误响应。由协议设计者决定使用什么代码,但如果出现错误,应该有一个非 2xx 响应。第 2 级介绍了使用 HTTP 动词和 HTTP 响应代码。

+

+这里有一个不一致的地方。REST 倡导者谈论使用所有 HTTP 动词。他们还通过说 REST 试图从 Web 的实际成功中学习来证明他们的方法是正确的。但是万维网在实践中很少使用 PUT 或 DELETE。更多地使用 PUT 和 DELETE 有合理的理由,但网络的存在证明不是其中之一。

+

+Web 存在支持的关键元素是安全(例如 GET)和非安全操作之间的强分离,以及使用状态代码来帮助传达遇到的各种错误。

+

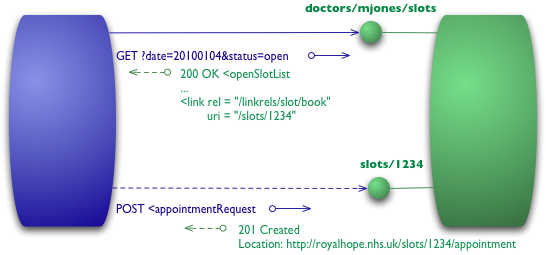

+## 3 级 - 超媒体控制

+

+最后一层介绍了一些经常听到的东西,它被称为 HATEOAS(超文本作为应用程序状态的引擎)它解决了如何从列表中获取空缺职位以了解如何进行预约的问题。

+

+

+

+```

+我们从在级别 2 中发送的相同初始 GET 开始

+

+GET /doctors/mjones/slots?date=20100104&status=open HTTP/1.1

+Host: royalhope.nhs.uk

+但回应有一个新的元素

+HTTP/1.1 200 OK

+[various headers]

+

+

+

+

+

+

+

+

+

+```

+

+每个插槽现在都有一个链接元素,其中包含一个 URI,告诉我们如何预约。

+

+超媒体控件的重点是它们告诉我们下一步可以做什么,以及我们需要操作的资源的 URI。我们不必知道在哪里发布我们的预约请求,响应中的超媒体控件会告诉我们如何去做。

+

+POST 将再次复制 2 级的

+

+```

+POST /slots/1234 HTTP/1.1

+[various other headers]

+

+

+

+

+

+HTTP/1.1 201 Created

+Location: http://royalhope.nhs.uk/slots/1234/appointment

+[various headers]

+回复包含许多超媒体控件,用于接下来要做的不同事情

+

+

+

+

+

+

+

+

+

+

+

+```

+

+我应该强调,虽然 RMM 是一种思考 REST 元素的好方法,但它并不是 REST 本身级别的定义。Roy Fielding 明确表示,[3 级 RMM 是 REST 的先决条件](http://roy.gbiv.com/untangled/2008/rest-apis-must-be-hypertext-driven)。与软件中的许多术语一样,REST 有很多定义,但自从 Roy Fielding 创造了这个术语,他的定义应该比大多数人更重要。

+

+我发现这个 RMM 的有用之处在于它提供了一个很好的循序渐进的方式来理解restfulness.思维背后的基本思想。因此,我认为它是帮助我们了解概念的工具,而不是应该在某种评估机制中使用的东西。我认为我们还没有足够的示例来真正确定 restful 方法是集成系统的正确方法,我确实认为这是一种非常有吸引力的方法,并且在大多数情况下我会推荐这种方法。

+

+这个模型的吸引力在于它与常见设计技术的关系。

+

+- 级别 1 通过使用分而治之,将大型服务端点分解为多个资源来解决处理复杂性的问题。

+

+- Level 2 引入了一组标准的动词,以便我们以相同的方式处理类似的情况,消除不必要的变化。

+

+### 局限:

+

+#### 不是所有业务都可以被表示为资源

+

+这在构建REST API时是经常会碰到的,我们不能正确表示资源,所以被迫采用了其他实际。

+

+例如,一个简单的用户登入登出,如果抽象为资源可能变成了创建一个会话, 即`POST /api/session`,这其实远不如`POST /login`来的直观。

+

+又比如,一个播放器资源,当我们要播放或停止时,一个典型的设计肯定是`POST /player/stop`, 而如果要满足REST规范,停止这个动作将不复存在,取而代之的是`播放器状态`,API形如 `POST /player {state:"stop"}`。

+

+以上两例都展示了,REST在某些场景下可能并不能提供良好的表现力。

+

+## 基于 HTTP+JSON 的类 REST API 设计

+

+http://www.ruanyifeng.com/blog/2014/05/restful_api.html

+

+##### 一、协议

+

+API与用户的通信协议,总是使用[HTTPs协议](https://www.ruanyifeng.com/blog/2014/02/ssl_tls.html)。

+

+##### 二、域名

+

+应该尽量将API部署在专用域名之下。

+

+> ```javascript

+> https://api.example.com

+> ```

+

+如果确定API很简单,不会有进一步扩展,可以考虑放在主域名下。

+

+> ```javascript

+> https://example.org/api/

+> ```

+

+##### 三、版本(Versioning)

+

+应该将API的版本号放入URL。

+

+> ```javascript

+> https://api.example.com/v1/

+> ```

+

+另一种做法是,将版本号放在HTTP头信息中,但不如放入URL方便和直观。[Github](https://developer.github.com/v3/media/#request-specific-version)采用这种做法。

+

+##### 四、路径(Endpoint)

+

+路径又称"终点"(endpoint),表示API的具体网址。

+

+在RESTful架构中,每个网址代表一种资源(resource),所以网址中不能有动词,只能有名词,而且所用的名词往往与数据库的表格名对应。一般来说,数据库中的表都是同种记录的"集合"(collection),所以API中的名词也应该使用复数。

+

+举例来说,有一个API提供动物园(zoo)的信息,还包括各种动物和雇员的信息,则它的路径应该设计成下面这样。

+

+> - https://api.example.com/v1/zoos

+> - https://api.example.com/v1/animals

+> - https://api.example.com/v1/employees

+

+##### 五、HTTP动词

+

+对于资源的具体操作类型,由HTTP动词表示。

+

+常用的HTTP动词有下面五个(括号里是对应的SQL命令)。

+

+> - GET(SELECT):从服务器取出资源(一项或多项)。

+> - POST(CREATE):在服务器新建一个资源。

+> - PUT(UPDATE):在服务器更新资源(客户端提供改变后的完整资源)。

+> - PATCH(UPDATE):在服务器更新资源(客户端提供改变的属性)。

+> - DELETE(DELETE):从服务器删除资源。

+

+##### 六、过滤信息(Filtering)

+

+如果记录数量很多,服务器不可能都将它们返回给用户。API应该提供参数,过滤返回结果。

+

+下面是一些常见的参数。

+

+> - ?limit=10:指定返回记录的数量

+> - ?offset=10:指定返回记录的开始位置。

+> - ?page=2&per_page=100:指定第几页,以及每页的记录数。

+> - ?sortby=name&order=asc:指定返回结果按照哪个属性排序,以及排序顺序。

+> - ?animal_type_id=1:指定筛选条件

+

+参数的设计允许存在冗余,即允许API路径和URL参数偶尔有重复。比如,GET /zoo/ID/animals 与 GET /animals?zoo_id=ID 的含义是相同的。

+

+##### 七、状态码(Status Codes)

+

+##### 八、错误处理(Error handling)

+

+如果状态码是4xx,就应该向用户返回出错信息。一般来说,返回的信息中将error作为键名,出错信息作为键值即可。

+

+> ```javascript

+> {

+> error: "Invalid API key"

+> }

+> ```

+

+##### 九、返回结果

+

+针对不同操作,服务器向用户返回的结果应该符合以下规范。

+

+> - GET /collection:返回资源对象的列表(数组)

+> - GET /collection/resource:返回单个资源对象

+> - POST /collection:返回新生成的资源对象

+> - PUT /collection/resource:返回完整的资源对象

+> - PATCH /collection/resource:返回完整的资源对象

+> - DELETE /collection/resource:返回一个空文档

+

+##### 十、Hypermedia API

+

+RESTful API最好做到Hypermedia,即返回结果中提供链接,连向其他API方法,使得用户不查文档,也知道下一步应该做什么。

+

+比如,当用户向api.example.com的根目录发出请求,会得到这样一个文档。

+

+> ```javascript

+> {"link": {

+> "rel": "collection https://www.example.com/zoos",

+> "href": "https://api.example.com/zoos",

+> "title": "List of zoos",

+> "type": "application/vnd.yourformat+json"

+> }}

+> ```

+

+上面代码表示,文档中有一个link属性,用户读取这个属性就知道下一步该调用什么API了。rel表示这个API与当前网址的关系(collection关系,并给出该collection的网址),href表示API的路径,title表示API的标题,type表示返回类型

+

+##### 十一、其他

+

+(1)API的身份认证应该使用[OAuth 2.0](https://www.ruanyifeng.com/blog/2014/05/oauth_2_0.html)框架。

+

+(2)服务器返回的数据格式,应该尽量使用JSON,避免使用XML。

\ No newline at end of file

diff --git a/_posts/2022-02-19-test-markdown.md b/_posts/2022-02-19-test-markdown.md

new file mode 100644

index 000000000000..29fb1f8560e8

--- /dev/null

+++ b/_posts/2022-02-19-test-markdown.md

@@ -0,0 +1,32 @@

+---

+layout: post

+title: 浅谈MVC、MVP、MVVM架构模式

+subtitle: MVC、MVP、MVVM这些模式是为了解决开发过程中的实际问题而提出来的,目前作为主流的几种架构模式而被广泛使用.

+tags: [架构]

+---

+# 浅谈MVC、MVP、MVVM架构模式

+

+MVC、MVP、MVVM这些模式是为了解决开发过程中的实际问题而提出来的,目前作为主流的几种架构模式而被广泛使用.

+

+### 一、MVC(Model-View-Controller)(最简单数据单线传递)

+

+#### MVC是比较直观的架构模式,用户操作->View(负责接收用户的输入操作)->Controller(业务逻辑处理)->Model(数据持久化)->View(将结果反馈给View).

+

+### 二、MVP(Model-View-Presenter)

+

+##### MVP是把MVC中的Controller换成了Presenter(呈现),目的就是为了完全切断View跟Model之间的联系,由Presenter充当桥梁,做到View-Model之间通信的完全隔离.

+

+Model提供数据,View负责显示,Controller/Presenter负责逻辑的处理.MVP与MVC有着一个重大的区别:在MVP中View并不直接使用Model,它们之间的通信是通过Presenter (MVC中的Controller)来进行的,所有的交互都发生在Presenter内部,而在MVC中View会直接从Model中读取数据而不是通过 Controller.

+

+- 特点:

+ 1. 各部分之间的通信,都是双向的.

+ 2. View 与 Model 不发生联系,都通过 Presenter 传递.

+ 3. View 非常薄,不部署任何业务逻辑,称为”被动视图”(Passive View),即没有任何主动性,而 Presenter非常厚,所有逻辑都部署在那里.

+

+### 三、MVVM(Model-View-ViewModel)

+

+##### 如果说MVP是对MVC的进一步改进,那么MVVM则是思想的完全变革.它是将“数据模型数据双向绑定”的思想作为核心,因此在View和Model之间没有联系,通过ViewModel进行交互,而且Model和ViewModel之间的交互是双向的,因此视图的数据的变化会同时修改数据源,而数据源数据的变化也会立即反应到View上.

+

+MVVM 模式将 Presenter 改名为 ViewModel,基本上与 MVP 模式完全一致.唯一的区别是,它采用双向绑定(data-binding):View的变动,自动反映在 ViewModel,反之亦然;

+

+这种模式跟经典的MVP(Model-View-Presenter)模式很相似,除了需要一个为View量身定制的model,这个model就是ViewModel.ViewModel包含所有由UI特定的接口和属性,并由一个 ViewModel 的视图的绑定属性,并可获得二者之间的松散耦合,所以需要在ViewModel 直接更新视图中编写相应代码.数据绑定系统还支持提供了标准化的方式传输到视图的验证错误的输入的验证.

\ No newline at end of file

diff --git a/_posts/2022-03-14-test-markdown.md b/_posts/2022-03-14-test-markdown.md

new file mode 100644

index 000000000000..c987d1f60a80

--- /dev/null

+++ b/_posts/2022-03-14-test-markdown.md

@@ -0,0 +1,1133 @@

+---

+layout: post

+title: Goroutines以及通道在 Golang 中的应用

+subtitle: Go 使用通道在 goroutine 之间共享数据。它就像一个发送和接收数据的管道。通道是并发安全的。因此,您不需要处理锁定。线程使用共享内存。这是与流程最重要的区别。但是,必须使用互斥锁、信号量等来避免与 goroutines 相反的任何问题。

+tags: [golang]

+---

+# Goroutines以及通道在 Golang 中的应用

+

+

+

+> 共享数据

+>

+> Go 使用**通道**在 goroutine 之间共享数据。它就像一个发送和接收数据的管道。通道是并发安全的。因此,您不需要处理锁定。线程使用共享内存。这是与流程最重要的区别。但是,必须使用互斥锁、信号量等来避免与 goroutines 相反的任何问题。

+

+## Example 1

+

+让我们以餐厅为例。餐厅有一些服务员和厨师。

+

+通常餐厅里顾客、服务员和厨师之间的互动是这样的:

+

+1. 一些服务员接受顾客的订单。

+2. 服务员将订单交给了一些厨师。

+3. 厨师烹饪订单。

+4. 厨师将煮好的菜交给某个服务员(不一定是接受订单的同一位服务员)。

+5. 服务员把菜递给顾客。

+

+如何在代码中表示这个流程?

+

+```

+package main

+

+import (

+ "fmt"

+ "math/rand"

+)

+

+func getWaiter() string {

+ waiters := []string{

+ "Waiter 1",

+ "Waiter 2",

+ "Waiter 3",

+ }

+ idx := rand.Intn(len(waiters))

+ return waiters[idx]

+

+}

+

+func getChef() string {

+ chefs := []string{

+ "Chef 1",

+ "Chef 2",

+ "Chef 3",

+ }

+ inx := rand.Intn(len(chefs))

+ return chefs[inx]

+

+}

+func takeOrlder(ordlerId int) {

+ waiter := getWaiter()

+ fmt.Printf("%s has taken orlder number %v\n", waiter, ordlerId)

+}

+

+func cookOrlder(ordlerId int) {

+ chef := getChef()

+ fmt.Printf("%s is cooking orlder number %v\n ", chef, ordlerId)

+}

+func bringOrlder(ordlerId int) {

+ waiter := getWaiter()

+ fmt.Printf("%s has brought dishes for orlder number %v\n", waiter, ordlerId)

+

+}

+func main() {

+ for orlderId := 0; orlderId < 8; orlderId++ {

+ takeOrlder(orlderId)

+ cookOrlder(orlderId)

+ bringOrlder(orlderId)

+ }

+}

+

+```

+

+假设我们有**N**个客户,那么我们将以线性方式一个一个地为客户服务。服务员**X**将接受顾客 1 的订单,将其交给某位厨师**Y。**主厨**Y**会做这道菜,然后交给服务员**Z。**服务员**Z**将把这道菜带给顾客 1。然后顾客 2、3…… **N**也会发生同样的过程。

+

+##### **disadvantage**

+

+如果很多顾客大约在同一时间到达餐厅,那么他们中的很多人将不得不等待甚至将他们的订单交给服务员。目前,餐厅无法充分发挥其员工(服务员和厨师)的潜力。换句话说,使用此策略将无法很好地扩展或在更短的时间内为大量客户提供服务。

+

+```

+//results are ...

+

+Waiter 3 has taken orlder number 0

+Chef 1 is cooking orlder number 0

+ Waiter 3 has brought dishes for orlder number 0

+Waiter 3 has taken orlder number 1

+Chef 2 is cooking orlder number 1

+ Waiter 1 has brought dishes for orlder number 1

+Waiter 2 has taken orlder number 2

+Chef 3 is cooking orlder number 2

+ Waiter 2 has brought dishes for orlder number 2

+Waiter 1 has taken orlder number 3

+Chef 3 is cooking orlder number 3

+ Waiter 2 has brought dishes for orlder number 3

+Waiter 1 has taken orlder number 4

+Chef 3 is cooking orlder number 4

+ Waiter 2 has brought dishes for orlder number 4

+Waiter 3 has taken orlder number 5

+Chef 1 is cooking orlder number 5

+ Waiter 3 has brought dishes for orlder number 5

+Waiter 3 has taken orlder number 6

+Chef 3 is cooking orlder number 6

+ Waiter 3 has brought dishes for orlder number 6

+Waiter 1 has taken orlder number 7

+Chef 3 is cooking orlder number 7

+ Waiter 2 has brought dishes for orlder number 7

+```

+

+

+

+##### solution?

+

+```

+// solution 1

+

+package main

+

+import (

+ "fmt"

+ "math/rand"

+ "sync"

+)

+

+func getWaiter() string {